LOGSIG-TANSIG

-

Upload

marjorie-juliana-chinchay-cuenca -

Category

Documents

-

view

233 -

download

0

Transcript of LOGSIG-TANSIG

-

Funciones de tranferencia (Logsig - Tansig) en Matlab

Marjorie Chinchay (1)Universidad Nacional de Loja

Karla Herrera (2)Universidad Nacional de Loja

Erika Masache (3)Universidad Nacional de Loja

Mg.Sc Henry Paz (4)Tutor del Trabajo

Las Redes Neuronales son un campo muy importante dentro de la Inteligencia Artificial. Elcerebro humano contiene aproximadamente 100,000 millones de neuronas. Las neuronas sonlos elementos bsicos de la estructura cerebral se interconectan masivamente para formar es-tructuras altamente complejas, no lineales y con funcionamiento paralelo. Es por ello que esteartculo permitir dar a conocer las funciones de transferencia logartmica (logsig) y transfe-rencia sigmoidal (tansig) a travs de la revisin de los conocimientos y ejemplos sencillos enMatlab adems del respectivo cdigo de la programacin con interfaz grfica.

I. INTRODUCCIN

Las redes neuronales son una implementacinmuy sencilla de un comportamiento local observadoen nuestros cerebros. El cerebro est compuestode neuronas, las cuales son elementos individualesde procesamiento. La informacin viaja entre lasneuronas, y basado en la estructura y ganancia de losconectores neuronales, la red se comporta de formadiferente.El cerebro humano contiene aproximadamente100,000 millones de neuronas. Cada neurona estconectada aproximadamente a otras 1000 neuronas,excepto en la corteza cerebral donde la densidadneuronal es mucho mayor.

II. ESTADO DEL ARTE

Neurona Modelo

Cada entrada es ponderada con un W apropiada. Lasuma de las entradas ponderadas y el sesgo forma laentrada a la funcin de transferencia F. Las neuronaspueden utilizar cualquier transferencia diferenciable lafuncin f para generar su salida.

Figura 1. Neurona

Red multicapa

Dentro de una red neuronal, los elementos de proce-samiento se encuentran agrupados por capas, una capaes una coleccin de neuronas; de acuerdo a la ubicacinde la capa en la RNA, esta recibe diferentes nombres:

Capa de entrada:. Recibe las seales de la entra-da de la red, algunos autores no consideran el vectorde entrada como una capa pues all no se lleva a caboningn proceso.

Capas ocultas:. Estas capas son aquellas que notienen contacto con el medio exterior, sus elementospueden tener diferentes conexiones y son estas las quedeterminan las diferentes topologas de la red

Capa de salida:. Recibe la informacin de la capaoculta y transmite la respuesta al medio externo.Si se considera una red con varias capas, o red multi-capa, cada capa tendr su propia matriz de peso W, supropio vector de ganancias b, un vector de entradas ne-tas n, y un vector de salida a. La versin completa y laversin en notacin abreviada de una red de tres capas,pueden ser visualizadas en las siguientes dos figurasrespectivamente.

Figura 2. Perceptrn multicapa

Para esta red se tienen R entradas, S1 neuronas enla primera capa, S2 neuronas en la segunda capa, lascuales pueden ser diferentes; las salidas de las capas 1

-

Marjorie Chinchay-Karla Herrera-Erika Masache Tutor: Mg.Sc Henry Paz

y 2 son las entradas a las capas 2 y 3 respectivamente,as la capa 2 puede ser vista como una red de una capacon R=S1 entradas, S1=S2 neuronas y una matriz depesos W2 de dimensiones S1xS2. Las redes multicapa

Figura 3. Perceptrn multicapa con n entradas

son ms poderosas que las redes de una sola capa, porejemplo, una red de dos capas que tenga una funcinsigmoidal en la primera capa y una funcin lineal en lasegunda, puede ser entrenada para aproximar muchasfunciones de forma aceptable, una red de una sola capano podra hacer esto.En general las redes neuronales se pueden clasificar dediversas maneras, segn su topologa, forma de apren-dizaje (supervisado o no supervisado), tipos de fun-ciones de activacin, valores de entrada (binarios ocontinuos).(Tanco Fernando, 2009, )Un resumen de esta clasificacin se observa en la si-guiente figura.

Figura 4. Clasificacin de las redes neuronales

Backpropagation

La Backpropagation es un tipo de red de aprendi-zaje supervisado, que emplea un ciclo propagacin adaptacin de dos fases. Una vez que se ha aplicadoun patrn a la entrada de la red como estmulo, estese propaga desde la primera capa a travs de las capassuperiores de la red, hasta generar una salida. La sealde salida se compara con la salida deseada y se calculauna seal de error para cada una de las salidas.

Las neuronas transforman una entrada no- res-tringida en una seal limitada Z

La funcin sigmoidal restringe el rango de Z en-tre 0 y 1.

Es diferenciable. Hay que tener presente que lano linealidad es una caracterstica resaltante deeste algoritmo.

Las entradas a la unidad de procesamiento sonejemplos de entrada o salidas de la capa previa

En una red cuya arquitectura incluye capas ocultas convarias neuronas (nodos) ocultas, podemos observar lassiguientes caractersticas de diseo.

Figura 5. Red neuronal con capas ocultas

Funciones de tranferencia Logartmica (Logsig)

Una neurona artificial est formada por un sumadory una funcin de activacin, representada por f(x).

Figura 6. Neurona Logsig

Est conectada hacia delante.

Esta red en particular tiene la capa de entrada,dos capas ocultas y la capa de salida.

La capa de entrada sirve solamente como un pun-to de distribucin.

Una neurona est asociada con un conjunto depesos que conecta a sus entradas. Los pesos enla capa uno terminan en las neuronas de la capauno.

Esta funcin toma los valores de entrada, los cualespueden oscilar entre ms y menos infinito, y restrin-ge la salida a valores entre cero y uno, de acuerdo a laexpresin:

a =1

1 + en

Es una funcin diferenciable lo que es til en algorit-mos de entrenamiento basados en derivadas. Esta fun-cin es comnmente usada en redes multicapa, como

UNIVERSIDAD NACIONAL DE [email protected], [email protected],[email protected]

2

-

Marjorie Chinchay-Karla Herrera-Erika Masache Tutor: Mg.Sc Henry Paz

la Backpropagation, en parte porque la funcin logsiges diferenciable.

Figura 7. Frmula de la Funcin Logsig

Funcin de transferencia sigmoidal (tansig).

Tambin es una funcin derivable pero con los lmi-tes de salida entre menos uno y uno.(Ledesma Sergio,2006, )

g(a) =2

1 + e2n 1

Figura 8. Frmula de la Funcin Tansig

III. APLICACIONES DE LAS FUNCIONES DETRANFERENCIA LOGSIG Y TANSIG

Estimacin de la resistencia del rotor de un motorasincrnico utilizando FPGA:

Realizada en la ciudad de Pamplona en Colombia,presenta la implementacin de Redes Neuronales Arti-ficiales en un FPGA, la finalidad es desarrollar un mo-delo en Sysgen capaz de estimar la resistencia rotricaen motores de induccin. En este caso la funcin deactivacin utilizada fue Tansig para la capa oculta yPurelin para la capa de salida.(Jaimes J. Juan Carlos,Gualdrn G. Oscar Eduardo, Daz R. Jorge Luis,2011,)

Prediccin mediante Redes Neuronales Artificiales(RNA) de la difusividad, masa, humedad, volumeny slidos en yacn (Smallantus sonchifolius) deshi-dratado osmticamente

Su objetivo fue evaluar la capacidad predictiva dela Red Neuronal Artificial (RNA) en el efecto de la

concentracin (30, 40, 50 y 60 % pp) y temperatura(30, 40 y 50C) de la solucin de fructooligosacaridos(FOS) en la masa, humedad, volumen y slidos en cu-bos de yacn osmodeshidratados, y en el coeficientede difusividad efectiva media del agua, con y sin enco-gimiento. Se aplic la RNA del tipo Feedforward conlos algoritmos de entrenamiento Backpropagation, tasade aprendizaje de 0.01, coeficiente de momento de 0.5,2 neuronas de entrada, 6 neuronas de salida, una capaoculta con 18 neuronas, 15 etapas de entrenamiento yfunciones de transferencia logsig y purelin.

Aplicacin de redes neuronales al modelado de des-cargas elctricas en gases

Se analizan tres estudios que utilizan las RNA, en elmodelado y anlisis de diferentes aspectos de las des-cargas elctricas en gases. Para este estudio se utilizauna red MLP de 3 capas: capa de entrada formada por2 neuronas con funciones de activacin tansig; una ca-pa oculta , en el que se busca el nmero de neuronasptimo, con funciones de activacin logsig y una ca-pa de salida de 2 neuronas, con funcin de activacinpurelin.(Universidad de Sevilla,2012, )

Entrenamiento de una red neuronal para la medi-cin indirecta de posicin

En este artculo se presenta una alternativa al uso deun sensor ptico para la medicin del entrehierro en elproceso de levitacin magntica. Esta consiste en uti-lizar la relacin no lineal entre el voltaje y la corrienteen la bobina, con el valor de entrehierro, para medireste ltimo de manera indirecta. Se presentan los resul-tados con respecto al diseo y entrenamiento de la redneuronal seleccionada, la cual aprende el patrn entrelas variables mencionadas. Adems se explica el cam-po de aplicacin del sensor indirecto propuesto, el cualdepende del tiempo de actualizacin requerido.

IV. IMPLEMENTACIN DE LAS FUNCIONESDE TRANSFERENCIA LOGSIG Y TANSIG EN

MATLAB

Para entrenar una red, generalmente se tienen 4 pa-sos en el proceso de entrenamiento.

1. Configurar los datos de entrenamiento. Losdatos de entrenamiento se definen en dos variable;una variable para los datos de entrada y otra variablepara los datos de salida. Para el desarrollo de nuestraaplicacin en matlab se utiliz se utiliz el siguientecdigo para obtener los datos para el entrenamiento dela red neuronal.Para acceder a cualquier componente de la aplicacinse utiliza la funcin handles.nombreComponente.En esta seccin de cdigo se va a deshabilitar todos loscomponentes y cajas de texto de la aplicacin, ya quese requiere que el usuario elija la funcin con la que va

UNIVERSIDAD NACIONAL DE [email protected], [email protected],[email protected]

3

-

Marjorie Chinchay-Karla Herrera-Erika Masache Tutor: Mg.Sc Henry Paz

a clasificar la red neuronal.% Desactiva botones y cajas de textoset(handles.txtentradas, Enable, o f f );set(handles.txtsalidas, Enable, o f f );set(handles.menuEntrenamiento, Enable, o f f );set(handles.txtcapas, Enable, o f f );set(handles.botonNeurona, Enable, o f f );set(handles.text1, Enable, o f f );set(handles.text2, Enable, o f f );set(handles.text3, Enable, o f f );set(handles.text6, Enable, o f f );set(handles.botonMostrarNeurona, Enable, o f f );set(handles.botonClasi f icar, Enable, o f f );set(handles.edit10, Enable, o f f );set(handles.edit11, Enable, o f f );set(handles.text9, Enable, o f f );set(handles.text10, Enable, o f f );

handles.output = hObject;% Update handles structure

guidata(hObject, handles);

Esta seccin de cdigo permitir elejir la funcinde transferencia, tanto logig como tansig.function menuFuncionCallback(hOb ject,eventdata, handles)

%obtiene el valor de la funcion (tansig y logsig)valorF=get(handles.menuFuncion, Value);globalValorFuncionswitchvalorFcase1err f ig = errordlg(Opcinnovlida,Errordeopcion);case2ValorFuncion = logsig;set(handles.menuEntrenamiento, Enable, on);set(handles.text6, Enable, on);guidata(hOb ject, handles);case3ValorFuncion = tansig;set(handles.menuEntrenamiento, Enable, on);set(handles.text6, Enable, on);guidata(hOb ject, handles);end

El usuario ingresa el numero de capas, como pasosiguiente dar clic en el botn neuronas que permitirestablecer el nmero de neuronas por capas.function botonNeuronaCallback(hOb ject,eventdata, handles)numCapas= str2num(get(handles.txtcapas, S tring));%ObtienelasneuronasporcadacapaglobalValorFuncion%secreanvariablesvalorglobalvectorcapas

vectorcapas = [];globalvector f uncporcapavector f uncporcapa = ;%cicloparaagregarneuronasaalnumerodecapasf orn = 1 : 1 : numCapas

if n == numCapasne = str2num(get(handles.txtentradas,S tring));f ila = ne(:, 1);nume = size( f ila);numenumentradas = nume(1);vectorcapas(n) = numentradas;vector f uncporcapa(n) = ValorFuncion;elsetexto1 = Numerodeneuronasparalacapa;texto2 = num2str(n);textocompleto = [texto1texto2];prompt = textocompleto;dlgtitle = Numerodeneuronasporcapa;answer = inputdlg(prompt, dlgtitle);vectorcapas = [vectorcapasstr2num(answer1, 1)];vector f uncporcapa(n) = ValorFuncion;end

end

En esta parte de cdigo el usuario establecer elentrenamiento para la red neuronal.

function menuEntrenamientoCallback(hOb ject,eventdata, handles)%ObtieneelentrenamientovalorE = get(handles.menuEntrenamiento, Value);globalValorEntrenamiento%recorreelvectordeotraswitchvalorEcase1%muestraelmensa jedeerrorerr f ig = errordlg(Opcinnovlida,Errordeopcion);case2ValorEntrenamiento = traingdx;set(handles.txtentradas, Enable, on);set(handles.txtsalidas, Enable, on);set(handles.txtcapas, Enable, on);set(handles.botonNeurona, Enable, on);set(handles.text1, Enable, on);set(handles.text2, Enable, on);set(handles.text3, Enable, on);set(handles.text6, Enable, on);set(handles.botonMostrarNeurona,Enable, on); set(handles.botonClasi f icar,Enable, on);

UNIVERSIDAD NACIONAL DE [email protected], [email protected],[email protected]

4

-

Marjorie Chinchay-Karla Herrera-Erika Masache Tutor: Mg.Sc Henry Paz

set(handles.edit10, Enable, on);set(handles.edit11, Enable, on);set(handles.text9, Enable, on);set(handles.text10, Enable, on);...end

Este grupo de sentencias permitir obtener losparmetros definidos en las funciones anteriores paracrear la red neuronal.

function botonClasificarCallback(hOb ject,eventdata, handles)re f reshdata

% Obtencion de entradasP=get(handles.txtentradas, S tring);T = get(handles.txtsalidas, S tring);EC = get(handles.edit10, S tring);ER = get(handles.edit11, S tring);

a = size(T);

errfig = errordlg(Datos Incorrectos,rror de opcion);P=str2num(get(handles.txtentradas, S tring));T = str2num(get(handles.txtsalidas, S tring));EC = str2double(get(handles.edit10, S tring));ER = str2double(get(handles.edit11, S tring));globalValorEntrenamientoglobalvector f uncporcapaglobalvectorcapas

2. Crear el objeto red: funcin newff. Una vezque se tiene los datos de entrada y salida deseada,para entrenar una red con conexin hacia adelantenecesitamos crear el objeto red. La funcin newffcrea una red con conexin hacia adelante y requiere decuatro argumentos de entradas y devuelve el objeto dered.

1. El primer argumento es una matriz de los mni-mos y mximos b1 de las Ni entradas (Nix2 valo-res, para cada uno de los N elementos del vectorde entrada).

2. El segundo argumento es un arreglo que contienelos tamaos de cada capa.

3. El tercer argumento es un arreglo que contienelos nombres de las funciones de transferenciaque se usarn en cada capa.

4. El ltimo argumento contiene el nombre del al-goritmo de entrenamiento a ser usado.

El cdigo para la creacin y visualizacin de la redneuronal para la aplicacin en matlab se describe ensiguientes lneas de cdigo:%crea la neurona= net=newff(minmax(P),vectorcapas,vector f uncporcapa,ValorEntrenamiento);net.trainParam.epochs = EC;

net.trainParam.goal = ER;%net = train(net, P,T );

Y = sim(net, P);

axes(handles.axes3);%presentalagra f ica

plot(P,T, P,Y, o);%view(net);

handles.netguardada = net;guidata(hOb ject, handles); %end

function botonMostrarNeuronaCallback(hOb ject, eventdata, handles)a = handles.netguardada;view(a);

3. Entrenar la red: funcin train. Una vez quelos pesos y los bias han sido inicializados, la red estlista para ser entrenada. La red puede ser entrenadapara aproximacin de funciones (regresin no lineal),asociacin de patrones o clasificacin de patrones.El proceso de entrenamiento requiere un conjunto deejemplos que tenga un comportamiento apropiado parala red entradas p ( X) y salidas t ( Yd) .Duranteel entrenamiento los pesos y los bias de la red sonajustados iterativamente para minimizar la funcin decosto o error de la red net.performFcn.Para entrenar la red tenemos que utilizar la funcintrain:

>> net = train(net, input, target)

;Aparece un grfico en el que vemos la evolucindel entrenamiento. El objetivo a alcanzar es bajar deun gradiente de 1E-10 (por defecto). Vemos tambinque el nmero de iteraciones mximo, por defecto, es100.(Aguilar J. Jorge,2011, )Las principales funciones de entrenamiento train son:

trainbfg: BFGS quasi Newton.Requiere alma-cenamiento de la Hessian matrix aproximada ytiene ms clculo en cada iteracin, pero usual-mente onverge en pocas iteraciones

trainbr:Regularizacin Bayesiana. Modifica-cin del algoritmo de entrenamiento Levenber-

UNIVERSIDAD NACIONAL DE [email protected], [email protected],[email protected]

5

-

Marjorie Chinchay-Karla Herrera-Erika Masache Tutor: Mg.Sc Henry Paz

gLevenberg Marquardt para producir redes quegeneralizan bien. Reduce la dificultad de deter-minar la arquitectura ptima de la red.

traincgb:Algoritmo de gradiente conjugado, Po-well Beale. Requerimientos de almacenamientoligeramente mayores que traincgp. Generalmen-te convergencia ms rpida

traincgf:Algoritmo de gradiente conjugadoFletcher Reeves. Tiene los Requerimientos dealmacenamiento menores de los algoritmos degradiente conjugado

traincgp: Algoritmo de gradiente conjugado Po-lak Ribire. Requerimientois de almacenamientoligeramente mayores que traincgf. CXonvergen-cia ms rpida sobre algunos problemas

traingd:Gradiente descendente bsico, puedeusarse en entrenamiento de modo incremental

traingda:Gradient descent adaptive

traingdm:Gradiente descendente con momen-tun. Generalmente ms rpido que traingd. Pue-de usarse en entrenamiento de modo incremental

traingdx:Tasa de aprendizaje adaptativa. Entre-namiento ms rpido que traingd, pero solo pue-de ser usado en modo de entrenamiento batch(por lotes)

trainlm:Algoritmo Levenberg Marquardt. El al-goritmo de entrenamiento ms rpido para redesde tamao moderado. Tiene caractersticas de re-duccin de memoria para conjuntos de entrena-miento grandes

trainoss:Mtodo One step secant. Compromisoentre los mtodos gradiente conjugado mtodosquasiNewton.

trainrp:Backpropagation flexible. Simple algo-ritmo de entrenamiento en modo batch, con r-pida convergencia y mnimos requerimientos dealmacenamiento.

trainscg:Algoritmo de gradiente conjugado es-calado (Scaled conjugate gradient). Solo el al-goritmo de gradiente conjugado que no requierebsqueda lineal. Un algoritmo de entrenamientode propsito general, muy bueno.

trainb:Batch training weight bias learning

trainc:Cyclical order inc. training learning f.

trainr:Random order inc. training learning f.

4. Simular la respuesta de la redpara nuevas entradas: funcin sim.

>> output = sim(net, input)

La funcin sim se utiliza para simular la red y as cal-cular las salidas.

V. RESULTADOS

EJEMPLOS DE LOGSIG Y TANSIG ENMATLAB

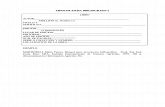

Se utilizar las matriz de entrada y salidas que sedescribe a continuacin para obtener el resultado de laaplicacin realizada en el programa de Matlab:

Logsig

Crear una red neuronal que utilice el entrenamientotraingd con los siguientes datos de entrada y salida,conla funcin de transferencia logsig.

net = newff([2 7], [5,1], logsig,logsig, traingd);

P=[3 7 2];T=[1 7 4];net.trainParam.epochs=100;net.trainParam.goal=0.00001;net = train(net, P, T);sim(net, P)

Figura 9. Ejecucin de la Funcin Logsig en Matlab

La Red neuronal nos queda como en la siguiente figura:

Figura 10. Salida de la Red Neuronla con la FuncinLogsig

UNIVERSIDAD NACIONAL DE [email protected], [email protected],[email protected]

6

-

Marjorie Chinchay-Karla Herrera-Erika Masache Tutor: Mg.Sc Henry Paz

Tansig

Crear una red neuronal que utilice el entrenamientotrainbr con los siguientes datos de entrada y salida,conla funcin de transferencia tansig.

net = newff([2 3], [5,1], tansig,tansig, trainbr);

P=[3 6 2];T=[2 4 8];net.trainParam.epochs=10000;net.trainParam.goal=0.00001;net = train(net, P, T);sim(net, P)

Figura 11. Ejecucin de la Funcin Tansig en Matlab

La Red neuronal nos queda como en la siguiente figura:

Figura 12. Salida de la Red Neuronal con la FuncinTansig

VI. CONCLUSIONES

Las funciones de activacin logsig y tansig sondiferenciables, por ello son utilizadas para lasRedes Multicapa BackPropagation debido a quetambin es diferenciable, es decir sirven para re-solver problemas no lineales.

Las funciones de activacin logsig y tansig sonutilizadas en varias reas, siendo su principal

aplicacin el clculo de probabilidades y predic-ciones.

La programacin en Matlab exige un nivel me-dio o alto de conocimientos acerca de su funcio-namiento, puesto que la herramienta no presentaningn tipo de ayuda acerca de los errores pro-ducidos; a diferencia de otros entornos de desa-rrollo como por ejemplo NetBeans.

Matlab utiliza un intrprete puesto que no nece-sita la declaracin de variables con su tipo de da-tos antes de su utilizacin.

Referencias

Ledesma Sergio, (2006). Las Redes Neuronales implementa-cin y consideraciones prcticas. Logsig-Tansig, 10:413.

Tanco, Fernando (2009). Introduccin a las Redes Neurona-les Artificiales. 4:912.

Jaimes J. Juan Carlos, Gualdrn G. Oscar Eduardo,Daz R. Jorge Luis (2011) 2:110. Estimacinde la resistencia del rotor de un motor asincrnicoutilizando FPGA Universidad de Pamplona, Colombiahttps://www.google.com.ec/url?sa=trct=jq=esrc=ssource=webcd=10cad=rjauact=8ved=0CHQQFjAJurl=http %3A %2F %2Frevistas.ustatunja.edu.co %2Findex.php%2Fingeniomagno %2Farticle %2Fdownload %2F59%2F49ei=TdNqU43eIoKMyATL6YGQCAusg=AFQjCNGPcnsrM84GZrPOiXqH0Y47s1QnBwbvm=bv.66330100,d.aWw

Aguilar Jaramillo Jorge (2011) Apuntes de InteligenciaArtificial Pontificia Universidad Catlica del Ecuadorhttp://www.flacsoandes.org/comunicacion/aaa/imagenes/publicaciones/pub30.pd fUiversidaddeS evilla(2012)Aplicacinderedesneuronalesalmodeladodedescargaselctricasengaseshttp : //bibing.us.es/proyectos/abreproy/70196/ f ichero/Capitulo5%252Fcapitulo5.pd f

Figura 13. Licencia

UNIVERSIDAD NACIONAL DE [email protected], [email protected],[email protected]

7

I. INTRODUCCINII ESTADO DEL ARTENeurona ModeloRed multicapaCapa de entrada:Capas ocultas:Capa de salida:

BackpropagationFunciones de tranferencia Logartmica (Logsig)Funcin de transferencia sigmoidal (tansig).

III. APLICACIONES DE LAS FUNCIONES DE TRANFERENCIA LOGSIG Y TANSIGEstimacin de la resistencia del rotor de un motor asincrnico utilizando FPGA: Prediccin mediante Redes Neuronales Artificiales (RNA) de la difusividad, masa, humedad, volumen y slidos en yacn (Smallantus sonchifolius) deshidratado osmticamenteAplicacin de redes neuronales al modelado de descargas elctricas en gasesEntrenamiento de una red neuronal para la medicin indirecta de posicin

IV. IMPLEMENTACIN DE LAS FUNCIONES DE TRANSFERENCIA LOGSIG Y TANSIG EN MATLABV. RESULTADOSEJEMPLOS DE LOGSIG Y TANSIG EN MATLABLogsigTansig

VI. CONCLUSIONESReferencias