Reconocimiento Patrones Cap3

description

Transcript of Reconocimiento Patrones Cap3

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Introduccin

Recordamos: La forma ptima de realizar el proceso de clasificacin consiste en

la utilizacin del clasificador bayesiano:

Elegir wi si p(x |wi) P(wi) > p(x |wj) P(wi) ji

Para utilizarlo, sin embargo, es necesario conocer la forma de la distribucin condicional en cada clase p(x |wi) y la probabilidad a priori P(wi).

Problema: En la prctica las distribuciones de probabilidad no se conocen.

Solucin (aproximacin generativa): Estimar todas las distribuciones de probabilidad mediante un

conjunto de entrenamiento H. De esta forma obtenemos el modelo probabilstico mediante el cual se gener el conjunto de entrenamiento

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Aproximacin Generativa Objetivo:

Estimar p(x|wi) , P(wi), necesarios para aplicar el modelo de Decisin Bayesiano.

Informacin disponible: Un conjunto de muestras de entrenamiento H representativas de

las distintas clases, correctamente etiquetadas con su clase de pertenencia.

Esto es, H= H1 H2 ... Hc, donde cada Hi tiene las muestras de la clase wi

Asumiremos: Que las muestras de cada clase no proporcionan informacin

acerca de la otra clase. Las muestras en cada clase son independientes

Esto permite: Estimar p(x|wi) , P(wi) nicamente a partir de las muestras en Hi. Tenemos que resolver el problema de estimacin para cada clase

Problema: La estimacin de P(wi) es simple, sin embargo la estimacin de

p(x|wi) es un problema complejo

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Estrategias de Estimacin Estimacin Paramtrica

Se basa en suponer que la forma de p(x|wi) es conocida (gausiana, beta, etc...) y depende de un conjunto de parmetros i .

Principal Ventaja: Los mtodos de estimacin son ms simples y precisos

Principal Desventaja: Es necesario conocer la forma de la distribucin. Los mtodos suelen ser sensibles a errores en dicha forma.

Mtodos ms importantes: Estimacin por Mxima Verosimilitud. Estimacin mximo a posteriori Estimacin Bayesiana.

Estimacin no Paramtrica. No se realiza ninguna asuncin acerca de la forma de p(x|wi)

Principal Ventaja: Mtodos robustos Principal Desventaja: Mtodos complejos y que requieren un gran

nmero de muestras para una estimacin precisa. Mtodos ms importantes

Ventanas de Parzen. Vecinos ms prximos.

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Estimacin Paramrica (1)

Mtodos paramtricos Se asume que la forma de las funciones de densidad condicionales

son conocidas y dependen de un conjunto de parmetros i. Escribiremos esta dependencia como p(x|wi ,i). Por ejemplo para una normal multidimensional tendremos que i={i,i}

Sin embargo, se desconoce el valor verdadero del conjunto de parmetros que la determinan completamente. Este verdadero valor se estima a partir de un conjunto de entrenamiento mediante un estimador.

Es importante recordar que: El valor del estimador (estimacin) depende del conjunto de

entrenamiento y distintos conjuntos de entrenamiento proporcionan distintas estimaciones.

La estimacin no tiene por qu coincidir con el verdadero valor del parmetro.

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Estimacin Paramtrica (2) Simplificacion:

Las muestras de la clase wi slo dan informacin acerca del parmetro de dicha clase i,.

Esto permite trabajar con cada clase por separado y obtener c problemas de la forma:Utilizar un conjunto de muestras Hi tomadas de forma independiente de p(x | wi ,i ) para estimar i

Notacin: Eliminaremos de la notacin la dependencia de la clase para

simplificar la escritura y escribiremos p(x | ) en vez de p(x | wi ,i )y H en lugar de Hi.

No obstante debemos recordar siempre que estamos utilizando las muestras de una nica clase y estimado los parmetros para esa clase.

Por tanto para completar el clasificador debemos tener resuelto el problema de estimacin para cada clase por separado.

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

EMV: Mtodo Idea:

Encontrar los valores del conjunto de parmetros que hace mxima la verosimilitud del conjunto de entrenamiento

Obtencin de la mxima verosimilitud Si H={x1,x2,...,xn} son muestras generadas de forma independiente de la funcin de densidad p(x| ) entonces

1.- Calcular la funcin de verosimilitud de todas las muestras:

2.- Obtener el valor de que hace mxima la funcin de verosimilitud L.Para ello puede resolverse la ecuacin:

, o de forma equivalente:

Ejemplo: Estimar la media , y la matriz de una distribucin normal por

EMV, a partir de un conjunto H={x1,x2,...,xn}.

=

==

n

kkpHpL

1)|()|( x

EMV

0

0

==))|(ln(

)|(

HpHp

p(H|)

TEMVEMV

1EMV

1EMV ))((1,1 xxx ==

==

k

n

kk

n

kk nn

EMV

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

EMV: Propiedades El EMV tiene propiedades muy deseables:

Es asintticamente insesgado: Significa que la media sobre los valores de los posibles

conjuntos de entrenamiento da el verdadero valor del parmetro cuando el nmero de muestras del conjunto de entrenamiento tiende a infinito

Es asintticamente consistente:Significa que cuando el nmero de muestras del conjunto de entrenamiento tiende a infinito el valor del estimador estararbitrariamente cerca del verdadero valor del parmetro.

Es asintticamente eficiente: Significa que alcanza la menor varianza que cualquier

estimador puede tener cuando el nmero de muestras del conjunto de entrenamiento tiende a infinito

=

)E(lim EMVn

( ) 1Plim EMV =

n

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Estimacin de las probabilidades a priori

La estimacin mediante EMV de las probabilidades a priori P(wi) es simple y se calcula mediante: P(wi)=|Hi| / |H|, |.|=nmero de elementos

Esto es, el cociente entre el nmero de elementos de la clase wien el conjunto de entrenamiento y el nmero total de elementos del conjunto de entrenamiento

Un inciso... De la misma forma puede comprobarse que la decisin tomada

utilizando el conjunto de entrenamiento para el ejemplo de los rdalos y salmones del tema anterior est basada en la estimacin por mxima verosimilitud de las correspondientes funciones de distribucin para cada clase.

^

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

-1.5 -1 -0.5 0 0.5 1 1.5 2 2.5 3

-2

-1

0

1

2

3

Distribuciones verdaderas:

p(x | w1 ,1 )~ , p(x | w2 ,2 )~

P(w1)=0.5, P(w2)=0.5 Clasificacin:

Conjunto de testeo: 50 muestras por clase

Conjunto de entrenamiento: 50 muestras por clase

Estimacin:

Error de clasificacin estimado: 0.24

Error bayesiano: 0.23

Clasificacin tras estimacin por EMV: Ejemplo

1001

,

00

N

1001

,

11N

Ejemplo de clasificacin tras estimacin mediante EMV Circulos: muestras de la clase 1Aspas: muestras de la clase 2Linea negra: Frontera de decisin a partir de la estimacinLinea roja: Frontera de decisin bayesiana

53.009.009.002.0

,

32.045.0

~)|( Np1

wx

23.073.073.032.2

,

16.052.0

~)|( Np2

wx

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Mtodos no Paramtricos (M.n.P.) Mtodos no Paramtricos:

Es un conjunto de mtodos que no necesita informacin acerca de la forma de las funciones de densidad condicionales p(x | wi)

Simplificacin: Se asume que los elementos de Hi solo dan informacin sobre dicha clase.

Esto permite resolver c problemas independientes Notacin:

Eliminaremos de la notacin la dependencia de la clase para simplificar la escritura y escribiremos p(x) en lugar de p(x | wi ) y H en lugar de Hi

No obstante debemos recordar siempre que estamos utilizando las muestras de una nica clase y por tanto para completar el clasificador debemos tener resuelto el problema de estimacin para cada clase por separado.

Algunos Procedimientos: Ventanas de Parzen

Se estima la funcin de densidad p(x) examinando el conjunto de entrenamiento H en un entorno de x que cuya forma no depende de H

k- Vecinos ms prximos Se estima la funcin de densidad p(x) examinando el conjunto de entrenamiento

H en un entorno de x cuya forma depende de H

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

M.n.P.: Aspectos Generales Objetivo: Estimar p(x) a partir de H Metodologa:

Disear una regin R del espacio de caractersticas, que contiene a x y lo suficientemente pequea para asumir que la funcin de densidad p(x) es aproximadamente constante.

A partir de las n muestras independientes presentes en H, generadas de acuerdo a la funcin de densidad p(x), y siendo k el nmero de muestras que caen en R estimar:

xx d ,)( ==R

VV

nkp

x

R

k=5n=18V=rea de R

Ejemplo de Estimacin de p(x)

Vp 18/5)( =x

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Convergencia de la Estimacin Convergencia

Una condicin deseable es la convergencia de la estimacin de p(x) a su verdadero valor cuando el tamao del conjunto de entrenamiento tiende a infinito.

Condiciones de Convergencia Para expresar la dependencia de k y V del tamao del conjunto de

entrenamiento n escribiremos:

Con el siguiente resultado se asegura la convergencia de dicha estimacin:

Esto es, cuando el tamao del conjunto de entrenamiento tiende a infinito tiene que cumplirse:

1. El volumen de la regin Vn debe tender a 02. El nmero de puntos en la regin debe tender a 3. La frecuencia relativa de los puntos en la regin debe tender a 0

)()(lim0/lim, lim,0 lim xx ppnkkV nn

nn

nn

nn

====

)(n

nn V

nkp =x

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Ventanas de Parzen:Preliminares Histogramas

La forma ms simple de estimacin de funciones de densidad es mediante la creacin de un histograma de frecuencias relativas.

En un histograma unidimensional se puede elegir el nmero de celdas M y el punto de comienzo de la divisin en intervalos

Desventajas Cuando se tienen d caractersticas no es factible construir el

histograma debido a que el nmero de celdas es exponencial ( Md ) en el nmero de caractersticas d.

Estimacin de funciones de densidad mediante histogramas para distintos valores de M

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Ventanas de Parzen:Introduccin Idea inicial:

Fijar un tamao de regin, construirla nicamente alrededor del punto x para el que se desea estimar su probabilidad y aplicar la frmula de los mtodos no paramtricos:

Vamos a formalizarlo: Caso unidimensional

La celda es un intervalo centrado en x de longitud h Hallaremos k de una forma un tanto especial:

Primero definimos la funcinEntonces k=

Finalmente la estimacin es:

=

caso otro021||1)( tt

hVhVnV

hnV

nkp in

i

n

i

i=

==

== ==

,

1)(),(1))((1)(11

xxxx

xxx

=

n

ii hxx

1))((

x1 x2 x3 x4

x

h/2h/2

hp 43)( =x

x1 x2 x3 x4Ventanas de Parzen

)(V

nkp =x

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Ventanas de Parzen: Caso Multidimensional

Caso multidimensional La celda es un hipercubo centrado en x

y la longitud de cada lado es h

De nuevo hallamos k de una forma especial:Primero definimos la funcinigual a 0 salvo dentro del hipercubo centrado en 0 y de longitud de lado 1/2 donde vale 1.

Entonces k=

Finalmente la estimacin es:

h /2

- h /2

-h/2 h /2

Hipercubo en 2-D

==

caso otro021||1),...,,()( i21 xxxx d x

=

n

ii h

1))(( xx

di

n

i

n

i

i hVhVnV

hnV

nkp =

==

== ==

,

1)(),(1))((1)(11

xxxx

xxx

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Ventanas de Parzen:Funciones ncleo Problema:

La estimacin genera funciones de densidad

discontinuas (pues las funciones son discontinuas). Generalmente se suele trabajar con funciones de densidad continuas

Solucin Generalizar la nocin de histograma variando la funcin ncleo

utilizando por ejemplo una gausiana: G(x)=1/(2pih2)d/2 exp( (-1/2) xx) que suelen proporcionar una estimacin ms suave.

)(1)(1

i

n

inp xxx =

=

Grficos de: Richard O. Duda, Peter E. Hart, and David G. Stork, Pattern Classification. Copyright (c) 2001 por John Wiley & Sons, Inc.

Funciones ncleo gausianas para distintos valores de h

Estimacin de Parzen mediante las funciones ncleo gausianas para 5 muestras y distintos valores de h

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Todava mas problemas... La estimacin depende de h. Si h es muy grande la estimacin es

muy suave. Si por el contrario h es muy pequeo la estimacin suele tener variaciones bruscas inaceptables (se produce sobreajuste).

Una solucin: Dividir el conjunto de entrenamiento en dos partes: uno para testeo

y otro para validacin. Utilizar el conjunto de entrenamiento para definir distintas estimaciones en funcin de h. Posteriormente elegir aquel valor de h para el que la probabilidad del conjunto de validacin sea mxima.

Ventanas de Parzen: La eleccin de h

Estimacin de Parzen de una funcin de distribucin gausiana para distintos valores de h y n

Grficos de: Richard O. Duda, Peter E. Hart, and David G. Stork, Pattern Classification. Copyright (c) 2001 por John Wiley & Sons, Inc.

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

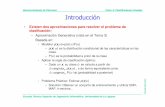

Distribuciones verdaderas:

p(x | w1 ,1 )~ , p(x | w2 ,2 )~

P(w1)=0.5, P(w2)=0.5

Clasificacin: Conjunto de testeo:

50 muestras por clase Conjunto de entrenamiento:

50 muestras por clase Valor ptimo calculado para h:

2.154 Error de clasificacin estimado:

0.32 Error bayesiano:

0.23-1.5 -1 -0.5 0 0.5 1 1.5 2 2.5 3

-2

-1

0

1

2

3

Clasificacin por Ventanas de Parzen: Ejemplo

1001

,

00

N

1001

,

11N

Ejemplo de clasificacin tras estimacin mediante ParzenCirculos: muestras de la clase 1Aspas: muestras de la clase 2Linea negra: Frontera de decisin a partir de la estimacinLinea roja: Frontera de decisin bayesiana

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Estimacin por k- vecinos ms prximos

Idea: Parece que en zonas con pocas muestras deberamos hacer la

regin grande mientras que en zonas con pocas muestras la podemos hacer pequea. Una idea sera entonces fijar el nmero de muestras que queremos en la regin alrededor del punto x para el que se desea estimar su probabilidad y aplicar la frmula de los mtodos no paramtricos:

)(V

nkp =x

Estimacin mediante k-vecinos (k=3,5) y 8 muestras Estimacin mediante k-vecinos en 2 dimensiones

Grficos de: Richard O. Duda, Peter E. Hart, and David G. Stork, Pattern Classification. Copyright (c) 2001 por John Wiley & Sons, Inc.

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Estimacin directa de p (wi |x) Recordemos:

El clasificador ptimo bayesiano se puede construir hallando la clase para la que es mxima la probabilidad a posteriori: p (wi |x)

Entonces: Supongamos que el conjunto de datos H contiene ni muestras en la

clase wi y n muestras en total. Supongamos que fijamos una regin R de volumen V para todas

las clases Como sabemos, debemos resolver un problema de estimacin por

clase. Para la clase wi la estimacin ser:

Entonces si utilizamos tendremos

La regla es simple: Seleccionar la clase con mayor nmero de elementos en la regin R.La regin R puede definirse mediante el esquema de las ventanas de Parzen o los k-vecinos. Este ltimo esquema lleva a la clasificacin por vecinos ms cercanos.

)|(kk

wp ii =xV

nkp iii =)|( wx

n

nwp ii =)(

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Clasificacin por el vecino ms prximo Clasificacin (1-vecino ms prximo)

Dado el conjunto H de muestras se clasifica x como perteneciente a la clase de su vecino ms prximo en H.

Probabilidad de Error Si P* es la probabilidad de error bayesiano (mnima), P la de la

regla 1-NN, c el nmero de clases y n el nmero de muestras en H:

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Clasificacin por k-vecinos ms prximos Clasificacin (k-vecinos ms prximos)

Dado el conjunto H de muestras se clasifica x como perteneciente a la clase mayoritaria entre sus k vecinos ms prximos de H.

Probabilidad de Error Se aproxima a la Probabilidad de Error Bayesiano, cuando tanto k,

como el nmero de muestras n, tienden a infinito. La probabilidad de error se puede acotar:

Qu valor elegir para k? Se suele dividir el conjunto de entrenamiento en dos partes: uno

para testeo y otro para validacin. Utilizar el conjunto de entrenamiento para construir el clasificador para distintos valores de k. Posteriormente elegir aquel valor de k para el que la probabilidad de error sea mnima sobre el conjunto de validacin

ekPPP 1*kNN* +

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Distribuciones verdaderas:

p(x | w1 ,1 )~ , p(x | w2 ,2 )~

P(w1)=0.5, P(w2)=0.5

Clasificacin: Conjunto de testeo:

50 muestras por clase Conjunto de entrenamiento:

50 muestras por clase Valor ptimo calculado para k:

8 Error de clasificacin estimado:

0.28 Error bayesiano:

0.23

Clasificacin por k-vecinos: Ejemplo

1001

,

00

N

1001

,

11N

-1.5 -1 -0.5 0 0.5 1 1.5 2 2.5 3

-2

-1

0

1

2

3

Ejemplo de clasificacin por k-vecinosCirculos: muestras de la clase 1Aspas: muestras de la clase 2Linea negra: Frontera de decisin a partir de la estimacinLinea roja: Frontera de decisin bayesiana

-

Reconocimiento de Patrones Tema 3: Estimacin de Distribuciones de Probabilidad

Escuela Tcnica Superior de Ingeniera Informtica. Universidad de La Laguna

Fern

an

do P

re

z N

ava

Resumiendo... En este tema hemos visto mtodos para estimar la estructura de

probabilidad necesaria para aplicar la regla de clasificacin bayesiana. Las buenas noticias...

Cuando la forma de la funcin de densidad condicional p(x | wi ) es conocida y depende nicamente de un vector de parmetros (caso paramtrico) se dispone de estimadores con buenas propiedades. Adems el coste computacional del clasificador depende del nmero de caractersticas.

Aun en el caso de que la forma de la funcin de densidad condicional p(x | wi ) sea desconocida (caso no paramtrico) se dispone tambin de mtodos de estimacin. Algunos muy simples como los k-vecinos.

Adems obtenemos un modelo probabilstico de la forma de generacin de los datos

Las malas noticias... La forma de p(x | wi ) raramente es conocida en problemas complejos.

Cuando la forma de p(x | wi ) es errnea el clasificador suele ofrecer malos resultados (no es robusto frente a errores en forma de la distribucin).

Los mtodos no paramtricos necesitan un gran nmero de muestras para ofrecer resultados precisos. Adems el coste computacional del clasificador depende del nmero de muestras.

Los mtodos no paramtricos son tan flexibles que pueden sufrir de sobreajuste. Es necesario fijar determinados parmetros para que esto no ocurra.