Midiendo y Evaluando... Ando

-

Upload

ursula-chigo -

Category

Documents

-

view

249 -

download

6

description

Transcript of Midiendo y Evaluando... Ando

2013

Úrsula García Chigo

Facultad de psicología UADY

Midiendo y Evaluando

Ando…

El objetivo de este e-book es poder recabar información

relacionada con la Evaluación y Medición del Aprendizaje,

haciéndolo de una manera interactiva y de fácil acceso con el

fin de poder proporcionar herramientas a cualquier población

estudiantil que quiera aproximarse a esta; incluyendo temas

relacionados con la construcción de pruebas y el análisis de

reactivos.

La importancia de los criterios actuales acerca de la

medición y evaluación en el ámbito educativo (CENEVAL,

ENLACE, etc.) hace que resulta necesario que el psicólogo sea

capaz de realizar esta tarea.

Siendo que este proyecto forma parte de la evaluación de

la propia materia el objetivo especifico de esta es: Adquirir

conocimientos y desarrollar habilidades necesarias para

elaborar, aplicar, informar resultados y evaluar las diferentes

técnicas para medir la adquisición de conocimientos y

habilidades mediante experiencias de aprendizaje que

permitan tener una visión crítica y global de la medición y

evaluación del aprendizaje en el aula.

Medición y Evaluación

del Aprendizaje

Clasificación de la información.

1. Medicion en psicología

2. Evaluación

3. Aprendizaje

4. Modelo por competencias

5. Taxonomia de Bloom

6. Validez

7. Confiabilidad

8. Estándares para la

evaluacion educativa

9. Teoría clásica de los tests

10. Teoría de la respuesta al item

11. Elaboracion de reactivos

Recomendaciones*

Medición… como el proceso de asignar una cantidad al atributo medido,

después de haberlo comparado con un patrón. Quesada (1991; en López, 2008)

Proceso de vincular conceptos abstractos con indicadores empíricos, el

cual se realiza mediante un plan explícito y organizado para clasificar (y

con frecuencia cuantificar) los datos disponibles (indicadores), en términos

del concepto que el investigador tiene en mente. Carmines y Zeller (1991, en Hernández, Fernández y Baptista, 2006)

Agregan que este "concepto" que se intenta conocer, puede ser una

realidad tanto física como social. Gómez-Peresmitré y Reidl (s/f)

Según Thorndike y Hagen (1998), cualquier campo la medición siempre

implica tres etapas:

1. Identificación y definición de la cualidad o el atributo que se va a

medir.

2. Determinación del conjunto de operaciones por medio de las cuales

se puede manifestar y percibir ese atributo.

3. Establecimiento de un conjunto de procedimientos o definiciones

para convertir las observaciones en enunciados cuantitativos de grado y

cantidad.

1

• MEDICIÓN EN PSICOLOGÍA

Referencias

1. Gómez-Peresmitré, G. y Reidl, L. (s/f). Metodología de investigación

en ciencias sociales. México: Universidad Autónoma de México.

Recuperado el 9 de enero de 2012,

de http://www.psicol.unam.mx/Investigacion2/pdf/lucy_gilda.pdf

2. López, B., Hinojosa, E. (2008). Evaluación del aprendizaje.

Alternativas y nuevos desarrollos. México: Trillas.

3. Thorndike, R. & Hagen, E. (1998). Medición y evaluación en

psicología y educación. 2° edición.

La evaluación psicológica es una de las tareas que realizan los

psicólogos con mayor frecuencia en distintos contextos (Fernández

Ballesteros, 1994).

La constante en todos los contextos es los que se aplica la

evaluación consiste en una serie de actividades de exploración, medida o

análisis de comportamientos o fenómenos psicológicos relativos a un sujeto

o grupo de sujetos y, que ello se realiza mediante un proceso de

indagación y toma de decisiones.

Se han propuesto numerosas definiciones de evaluación debido a la

pluralidad de actividades, contextos y objetivos psicológicos que se

establecen para una evaluación; entre esas definiciones tenemos:

Proceso en el cual el profesor y los alumnos juzgan si han logrado los

objetivos de enseñanza. Cronbach (1984)

Completo consistente en señalar los objetivos de un aspecto de la

educación y estimar el grado en que tales objetivos se han alcanzado.

Rodríguez y García (1992)

Proceso científico que utiliza instrumentos cuantitativos y cualitativos;

toma en cuenta registros, observaciones de conducta y trabajo del

alumno. López (1992)

2

• EVALUACIÓN

Para tener un concepto más

"adaptable" de evaluación, es

recomendable tener en cuenta que

antes de realizar una evaluación, se

debe de llevar a cabo un proceso de

medición adecuada, sin importar el

campo de estudio en el que se

trabaje, para así poder asignar un

valor o emitir un juicio adecuado de

nuestro objeto, tema o variable de

interés.

Se puede concluir que la evaluación es

un proceso mediante el cual se emite un juicio

de valor sobre una información previamente

obtenida (medición) que servirá para la toma

de decisiones.

La evaluación, en el contexto educativo,

puede servir para estimar el grado en que los

objetivos de un programa o actividad se han

alcanzado.

Referencias

López, B. & Hinojosa, E. (2008). Evaluación del aprendizaje.

Alternativas y nuevos desarrollos. México: Trillas.

Referencias

Papalia, Diane. (2009). Psicología del desarrollo humano: Mc Graw Hill, 11 edición.

Woolfolk, Anita. (2010). Psicología educativa. Cd. de México: Pearson, 11 edición

Aunque a lo largo de los años se ha intentado conocer

el aprendizaje y sus implicaciones, aún hoy no existe

consenso entre los teóricos en la forma de definir dicho

proceso.

El aprendizaje como un cambio relativo en el comportamiento, que refleja

una adquisición de conocimientos o habilidades a través de la experiencia

y que puede incluir el estudio, la instrucción, la observación o la práctica.

Los cambios en el comportamiento son razonablemente objetivos y, por

tanto, pueden ser medidos.

Papalia(1990)

El aprendizaje es un proceso que lleva a cabo la persona que aprende

cuando interactúa con el objeto y lo relaciona con sus experiencias

previas, aprovechando su capacidad de conocer para re-estructurar sus

esquemas mentales, enriqueciéndolos con la incorporación de un nuevo

material que pasa a formar parte de la persona que conoce. Ocurre

cuando la experiencia (incluyendo la práctica) genera un cambio

relativamente permanente en los conocimientos o las conductas de un

individuo.

Schunk (2008 en Woolfolk, 2010)

Pero esto es sólo un pequeño vistazo a la inmensidad de definiciones de un

sinfín de autores que tratan de dar al aprendizaje una definición.

.

3

• APRENDIZAJE

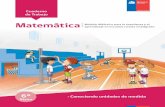

Referencia Secretaría de Educación Pública (2011). Plan de estudios 2011. Educación básica. México: Autor.

¿Qué es?

Es un “nuevo” modelo el cual surge como una

crítica al modelo instruccional que únicamente

se circunscribía en el conocimiento

declarativo, y que pocas veces tenía como

objetivo el desarrollo de habilidades por parte

de los alumnos que les permitieran elaborar,

analizar y reorganizar lo aprendido.

¿Qué son las competencias?

"Una competencia es la capacidad para responder a

diferentes situaciones, e implica un saber hacer

(habilidades) con saber (conocimiento), así como a la

valoración de las consecuencias de ese hacer (valores y

actitudes)”

Competencias para la vida, es otro tipo de competencias en las cuales se dirigen

conocimientos, habilidades, actitudes y valores hacia la consecución de objetivos

concretos. Este tipo de competencias incluye el aprendizaje permanente, el

manejo de la información, el manejo de situaciones, la convivencia y la vida en

sociedad.

Secretaría de Educación Pública (2011)

El objetivo central del Modelo por Competencias es asegurar que los aprendices

sean capaces de demostrar sus capacidades aprendidas después de que hayan

adquirido una combinación de conocimiento, habilidades y destrezas.

También podrías leer:

4

• Modelo por competencias

http://www.scielo.org.mx/pdf/rmie/v16n48/v16n48a11.pdf

http://www.ugr.es/~recfpro/rev123COL1.pdf

Desde 1948 un grupo de

educadores dirigidos por Benjamín

Bloom, asumieron la tarea de

clasificar los objetivos educativos.

Propusieron desarrollar un sistema de

clasificación en tres aspectos: el

cognitivo, el afectivo y el

psicomotor.

El trabajo del apartado cognitivo se terminó en 1956 y la

Taxonomía de Bloom fue hecha pública

Han pasado más de cincuenta años y la Taxonomía de Bloom

continúa siendo herramienta fundamental para establecer objetivos de

aprendizaje.

5

• Taxonomía de Bloom

Una taxonomía es la

ciencia que trata los

principios, métodos y

fines de la clasificación.

La idea central de esta

taxonomía es aquello que los

educadores deben querer que

los alumnos sepan, es decir son

los objetivos educacionales.

Tienen una estructura jerárquica

que va de lo más simple a lo

más complejo o elaborado,

hasta llegar al de evaluación.

En los años 90, un antiguo estudiante de Bloom, Lorin Anderson,

revisó la Taxonomía de su maestro y publicó, en el año 2001, la Taxonomía

Revisada de Bloom

Uno de los aspectos clave de esta revisión es el uso de verbos en

lugar de sustantivos para cada categoría y el otro, el cambio de la

secuencia de éstas dentro de la taxonomía.

A continuación se presenta una descripción de los escalones de la

taxonomía en su versión revisada.

Recordar (antes conocimiento): Cambio hacia la

acción. El sujeto es capaz de recordar información

anteriormente aprendida. Requiere que el alumno

repita y reconozca de una forma aproximada a

cómo las ha aprendido:

* Terminología

* Hechos específicos

* Convencionalismos

* Corrientes y Sucesiones

* Clasificaciones y categorías

* Metodología

* Principios y generalizaciones

* Teorías y estructuras

Comprender (antes comprensión):

El sujeto entienda "se hace suyo" aquello

que ha aprendido y esto lo demuestra

cuando es capaz de presentar la

información de otra manera, cuando la

transforma, cuando encuentra relaciones

con otra información, cuando se asocia a

otro hecho, cuando se saben decir las

posibles causas y consecuencias.

* Traducción

* Parafrasear

* Interpretación

* Resumen

* Extrapolación

Aplicar (antes aplicación): El sujeto es capaz de

utilizar aquello que ha aprendido. Cuando

aplica las destrezas adquiridas a nuevas

situaciones que se le presenten. Cuando utiliza la

información recibida en situaciones nuevas y

concretas para resolver problemas. Pueden

presentarse en forma de:

* Ideas generales,

* Reglas de procedimiento

* Métodos generalizados

* Ideas y teorías que deben

recordarse y aplicarse.

Analizar (análisis): Comprensión de las partes e

identificación entre ellas. Cuando el sujeto es

capaz de descomponer el todo en sus partes y

puede solucionar problemas a partir del

conocimiento adquirido. Cuando intenta

entender la estructura de la organización del

material informativo examinando las partes de

las cuáles se compone.

Recuperado de:

http://www.eduteka.org/TaxonomiaBloomDigital.php

http://www.cuautitlan.unam.mx/descargas/edudis/recursosacademicos/taxonomiadeb

loom.pdf

http://sitios.itesm.mx/va/calidadacademica/files/taxonomia.pdf

Requiere de las siguientes habilidades:

* Análisis de elementos

* Identificación de relaciones entre los elementos

* Reconocimiento de los principios de organización de la situación

problemática

* Identificación de conclusiones y fundamentación de enunciados.

Evaluar (antes síntesis): Emitir juicios respecto al valor

de un producto según opiniones personales a partir de

unos objetivos dados.

Requiere de habilidades como:

* Elaboración de un plan o conjunto de actos planeados

* Desarrollo de conjuntos de relaciones para clasificar o explicar datos.

* Deducción de proposiciones y relaciones.

* Construcción de un modelo o estructura.

* Reordenación de las partes en una secuencia lógica.

Crear (antes evaluación): Crear aplicando el

conocimiento y habilidades anteriores para producir

alguna cosa nueva u original.

Incluye:

* Juicios en función de evidencia interna (de exactitud lógica,

consistencia o criterio interno)

* Juicios en función de criterios externos (criterios seleccionados;

comparación de teorías, comparación de un trabajo con respeto a

normas, etc.)

En la creación de un instrumento de medición, es importante tomar en

cuenta 2 componentes importantes que son la validez y la

confiabilidad.

Algunas definiciones de validez son:

La exactitud con que pueden hacerse mediciones significativas y

adecuadas con un instrumento en el sentido que mide realmente el rasgo

que pretende medir

Ruiz; 2003

Grado en que un instrumento realmente mide lo que el investigador

pretende

Thorndike

Aspecto de la medición psicopedagógica vinculado a la comprobación y

estudio del significado de las puntuaciones obtenidas por el test".

Elosua (2003)

Esto es posible solo si poseemos los siguientes elementos:

Una base teórica sólida

Planteamiento claro de objetivos

Elección de una población o grupo representativo

Elección cuidadosa de instrumentos

Una administración cuidadosa del instrumento

Evidencias relacionadas con la validez

6

• Validez

Contenido

Grado en que la medición

representa al concepto medido. Criterio

Establece la validez de un

instrumento de medición

comparándola con algún

criterio externo.

Constructo

Es una variable medida que

tiene lugar dentro de una teoría

o esquema teórico

Referencias

Elousa, P. (2003). Sobre la validez de los tests. Psicothema, 15(2), 315-321. Gronlund, N. (1983). Medición y evaluación en la enseñanza. México: Pax.

Recuperado de:

http://www.slideshare.net/rosilfer/validez-confiabilidad

http://www.une.edu.pe/Titulacion/2013/exposicion/SESION-4-

Confiabilidad%20y%20Validez%20de%20Instrumentos%20de%20investigacion.pdf

Características

VALIDEZ

De contenido De criterio De constructo

Se determina antes de

la aplicación del

instrumento mediante

el juicio de expertos

Concurrente: si el

criterio se fija en el

presente

Predictiva: si el criterio

se fija en el futuro

Entre más se relacionen

los resultados del

instrumento con el

criterio, mayor será su

validez

Incluye tres etapas:

1. Relación teórica

entre los

conceptos

2. Correlación de

conceptos y

análisis

3. Interpretación de

la evidencia

empírica de

acuerdo con el

nivel en que

clarifica la

validez de un

constructo de

una medición

particular

Precauciones

La validez pertenece a los resultados de una prueba o

de un instrumento de evaluación y no al instrumento

mismo.

La validez es una cuestión de grado, debemos evitar

pensar sobre los resultados de la evaluación como

válidos o no válidos. La mejor manera de considerar la validez es en

términos de aquellas categorías que especifican grado como son: gran

validez, validez media y poca validez.

Gronlund (1983)

La obtención de confiabilidad es un requisito, más

aun si se quiere considerar válido dicho instrumento.

Algunas definiciones de confiabilidad son:

Grado en que un instrumento produce resultados consistentes y

coherentes. Es decir en que su aplicación repetida al mismo sujeto u

objeto produce resultados iguales.

Kerlinger (2002).

La confiabilidad de un instrumento de medición se refiere al grado en que

su aplicación repetida al mismo sujeto u objeto produce resultados iguales

(consistentes y coherentes)

Hernández, Fernández y Baptista (2006)

El instrumento de medida “se considera fiable si las medidas que se

obtienen a partir de él no contienen errores o los errores son

suficientemente pequeños”

Díaz, Batanero y Cobo (2003)

7

• Confiabilidad

Por ejemplo:

Si se midiera en este momento la temperatura

ambiental usando un termómetro y este

indicara que hay 22°C, un minuto más tarde

5°C, tres minutos después 40°C; dicho

termómetro no sería confiable.

Referencias

Díaz, C., Batanero, C. y Cobo, B. (2003). Fiabilidad y generalizabilidad: aplicaciones en

la evaluación educativa. Número, 54, 3-21.

Hernández, R., Fernández, C., Baptista, P. (2006). Metodología de la

investigación. México: McGraw Hill. 4° edición. Pp. 277.

Recuperado de:

http://www.gobierno.pr/NR/rdonlyres/CC1286A8-310F-48CF-AB2C-

D30417D9AF78/0/15confiabilidad.pdf

http://www.uned.es/psico-3-psicometria/val.htm

Cabe destacar que… cualquier instrumento en particular puede

tener cierto número de confiabilidades diferentes, según sea el grupo

involucrado y la situación en que se use. Así pues, es más apropiado

hablar de la confiabilidad de “los resultados de la prueba" o de “la

medición”, que de “la prueba” o “el instrumento”.

Confiabilidad Vs Validez

Es por ello que todo instrumento válido es confiable, no obstante el obtener

la confiabilidad no hace válido un instrumento… he aquí una analogía.

La confiabilidad es condición necesaria pero no suficiente de la validez.

Cualquier prueba que arroje resultados totalmente inconsistentes no

puede en forma alguna posible suministrar información veraz sobre el

comportamiento que se mide. Por otro lado, hay resultados de prueba

sumamente consistentes que pueden estar midiendo algo equivocado

que se pueden usar de maneras que no son apropiadas.

No valido

Confiable

Valido

Confiable

No valido,

No confiable

Desde 1999 diferentes asociaciones como la AERA y APA entre otras,

publicaron los “Estándares para la Evaluación Educativa y Psicológica”

Estos estándares proponen una serie de normativas que pretenden

que la medición y evaluación de lo educativo y lo psicológico sea

objetiva, confiable y válida.

Para realizar esto necesario primeramente sustentar el uso e

interpretación de las pruebas en evidencia empírica.

Varios autores han tratado de conciliar estos estándares para su utilización

en la evaluación del aprendizaje y en general en el campo educativo

para proveer a los profesionales de una guía que les permita llevar a cabo

un trabajo más sistematizado y eficiente.

1. Delimitar el constructo o dominio que se desea medir

Todos los autores coinciden en la importancia de delimitar el

constructo o dominio que se desea medir, que debe ser lo suficientemente

específico para no confundirlo con otros conceptos afines, tratando de

operacionalizar el constructo para que pueda ser susceptible a ser medida

(Linn, 2006; Downing, 2006; Muñiz y Fonseca-Pedrero, 2008).

2. Especificaciones de la prueba

Estos aspectos están relacionados con delimitar el contenido que

manejará la prueba y los procesos cognitivos a evaluar, hasta aspectos

como el requerimiento de la administración, el formato, tipo, número,

longitud de los ítems y la estructura del material. Posterior a este paso, Linn

(2006) agrega un paso más, que consiste en la validación de estas

especificaciones, a partir de una revisión de la evidencia empírica que

sustente el uso de estas especificaciones.

8

• Estándares para la Evaluación Educativa

3. Desarrollo de reactivo

Se ha de elegir previamente el formato de los ítems y se siguen las

directrices ideales para la elaboración de reactivos según el tipo que se

haya elegido (Linn, 2006; Downing, 2006; Muñiz y Fonseca-Pedrero, 2008). Para

conocer las recomendaciones de la elaboración de reactivos de opción

múltiple se recomienda leer al artículo de “Haladyna, Downing y Rodríguez

publicado en 2002 Y si se trata de preguntas abiertas, el publicado en 2007 por

Hogan y Murphy”.

4. Pilotaje del instrumento y depuración

Linn (2006), Muñiz y Fonseca-Pedrero (2008) proponen que el

instrumento sea pilotado para conocer el comportamiento de éste en un

escenario real, para que de esta forma se conozcan la propiedades de los

reactivos y puedan ser modificados y mejorados en caso de ser necesario.

5. Estimación de sus propiedades psicométricas

Posteriormente, se analizan las propiedades psicométricas del

instrumentos, que pueden ir desde su validez y confiabilidad hasta la

escala que será utilizada para homologar los resultados (Linn, 2006;

Downing, 2006; Muñiz y Fonseca-Pedrero, 2008). Para este punto es

importante seguir una metodología científica que permita obtener estos

datos, puesto que es importante conocer con exactitud la validez y

confiabilidad de los datos a utilizar (Linn, 2006).

6. Reportes de resultados y materiales de interpretación

Para finalizar, la última tarea consiste en proporcionar el marco

interpretativo que sirva para analizar los resultados obtenidos por

participantes y futuros evaluados (Linn, 2006; Downing, 2006; Muñiz y

Fonseca-Pedrero, 2008) el cual de forma ideal debería ser presentado en

forma de un manual de utilización (Muñiz y Fonseca-Pedrero, 2008).

Referencias:

Haladyna, T. M., Downing, S. M. y Rodríguez, M. C. (2002). A review of multiple-choice ítem-writing

guidelines for classroom assessment. Applied measurement in education, 15(3), 309-334.

Hogan, T. P. y Murphy, G. (2007). Recomendations for preparing and scoring constructed-response

items: What the experts say. Applied measurement in education, 20(4), 427-441.

Linn, R. (2006). The Standards for Educational and Psychological Testing: Guidance in Test

Development. (pp. 27-38). En S. M. Downing y T. M.

Recuperado de:

http://www.aera.net/EducationResearch/tabid/10065/Default.aspx

También conocida como el modelo clásico de la puntuación

verdadera y como la teoría del error de medida, la cual se fundamenta en

el modelo lineal propuesto por el psicólogo británico Charles Spearman.

Spearman considera que cualquier puntuación

observada de un test se puede entender como la suma

de dos componentes hipotéticos: puntuación verdadera

y error aleatorio. X=V + E

Donde X es la puntuación empírica obtenida, V la puntuación verdadera y

E el error de medida.

La puntuación empírica o verdadera se define como la puntuación

promedio que una persona obtendría al aplicársele múltiples tests

paralelos. Se puede considerar como una puntuación libre de error.

El error de medida es la diferencia entre la puntuación observada a través

de un test y la puntuación verdadera.

*Tests paralelos aquéllos que miden lo mismo aunque utilizando distintos

ítems, y los cuales tienen medias, varianzas y covarianzas iguales.

Tres grandes causantes de error en la medición psicológica:

1) La propia persona evaluada, que viene con

determinado estado de ánimo, actitudes y

temores, lo cual puede influir en la cuantía de

los errores.

2) El instrumento de medida utilizado, que con sus

características específicas puede influir

diferencialmente en los evaluados.

3) La aplicación, corrección e interpretación

hecha por los profesionales.

9

• Teoría clásica de los Test

Si todo se hace con rigor se minimizarán los errores

en todo el proceso, y es precisamente de lo que

nos informa la confiabilidad de la prueba, de los

errores cometidos.

Si la confiabilidad de una prueba es perfecta, las

puntuaciones empíricas y las verdaderas de las

personas en dicha prueba coincidirán, pero si no

es perfecta las puntuaciones verdaderas de las personas en el test se

estiman mediante un intervalo confidencial en torno a la puntuación

empírica.

Análisis de los ítems a partir del modelo clásico

Según la teoría clásica de los test, éste análisis conlleva examinar una serie

de indicadores por cada ítem a fin de determinar su calidad, y así

potenciar las propiedades de la prueba. Estos indicadores son los

siguientes:

Dificultad

Discriminación

Análisis de distractores

Fiabilidad

Validez

Dimensionalidad

Dificultad de los ítems

Un ítem es difícil o fácil “en función al número de personas que lo acierten

o fallen (…) [en relación] al número de personas que intentan responderlo

Para este análisis basta con obtener un indicador que proporcione el

índice de dificultad del ítem. García-Cueto (2005)

Discriminación de los ítems

Se espera que un ítem “bueno” sea respondido correctamente en su

mayoría por aquellos estudiantes con un buen desempeño, y que aquellos

que tuvieron un bajo desempeño fallen en mayor proporción el ítem.

(García-Cueto, 2005)

Para ayudar a interpretar las puntuaciones del índice de discriminación,

Ebel (1965) propone las siguientes clasificaciones:

Análisis de los distractores

Los distractores son “las distintas alternativas falsas o posibilidades de

respuesta incorrectas que tiene un ítem” Idealmente, todas ellas deberían

resultar igualmente atractivas de elegir por parte de los sustentantes para

que de esta funjan como distractores. Este análisis simplemente se basa en

observar la cantidad de sujetos que elije cada alternativa. Una alternativa

con pocas elecciones resulta en un distractor que paradójicamente no

distrae. García-Cueto (2005)

Dimensionalidad

Este indicador simplemente analiza la correlación que tienen los ítems entre

sí para conocer cómo se crean grupos entre ellos, bajo el supuesto de que

los ítems que correlacionan unos con otros forman un grupo, y que

correlacionan gracias a que miden un dimensión compartida (García-

Cueto, 2005).

Valores Interpretación

Igual o mayor que 0,40 El ítem discrimina muy bien

Entre 0,30 y 0,39 El ítem discrimina bien

Entre 0,20 y 0,29 El ítem discrimina poco

Entre 0,10 y 0,19 Ítem límite. Se debe mejorar

Menor de 0,10 El ítem carece de utilidad para discriminar.

Referencias:

Ebel, R. L. (1965). Measurgin educational achievement. Englewood: Prentice-Hall.

García-Cueto, E. (2005). Análisis de los ítems: Enfoque clásico (pp. 53-79). En J. Muñiz, A. M. Fidalgo,

E. García-Cueto, R. Martínez y R. Moreno. (2005). Análisis de los ítems. España: La Muralla.

Mateo, J. y Martínez, F. (2008). Medición y Evaluación Educativa. España: Editorial La Muralla S.A.

Muñiz, J. (1998). La medición de lo psicológico (en línea). España: Universidad de Oviedo.

Recuperado el 21 de mayo de 2012, de ttp:www.psicothema.com/pdf/138.pdf

En esta teoría se parte del supuesto de que

el comportamiento de un sujeto se puede

explicar en términos de una o varias

características personales, es decir, rasgos

que se encuentran latentes, pero que se

manifiestan a través del comportamiento

del individuo en el test o en las respuestas

a los ítems.

El desempeño “real” de un sujeto dependerá de su habilidad

únicamente, y ésta a su vez impactará en la probabilidad de que el

sujeto acierte en un ítem determinado. Es decir, cuanto mayor sean los

conocimientos que un sujeto tiene, mayor probabilidad tendrá de

resolver correctamente un problema. Así, la TRI, como su nombre lo

indica, evalúa el ítem, y no la prueba en su totalidad.

Hambleton, Swaminathan y Rogers (1991

Esta relación entre la

habilidad (o conocimiento)

y la probabilidad de

acertar el ítem queda

manifiesta en la Curva

Característica del Ítem

(CCI), en donde se grafica

esta relación

10

• Teoría de la respuesta al Item

Sin embargo, la TRI no siempre puede ser aplicada, puesto que para esto,

se deben de cumplir dos grandes requisitos:

1) lo que se pretenda medir debe ser unidimensional. De ahí que sea una

sola “habilidad” la que se evalúe. Sin embargo, esto no siempre es

posible puesto que muchos constructos psicológicos (tanto de

personalidad como cognitivos) dependen de otros factores es

indispensable que exista un factor dominante que esté influyendo en el

desempeño de la prueba.

2) Lo que mida un ítem, debe ser independiente a lo que mida otro ítem

(esto es conocido como “independencia local”), esto es, nada, a

excepción de la habilidad del sujeto, debe de influir en el desempeño

de éste en un ítem determinado.

(Hambleton, Swaminathan y Rogers, 1991; Muñiz,2010;

Así, en la TRI el desempeño del sujeto no depende de la escala de

medición, sino de la habilidad real del sujeto

Referencias

Hambleton, R. K. y Rusell, J. (1993). Comparison of Classical Test theory and Item

Response Theory and their aplications to test development. Instructional Topics in

Educactional Measurement,253-262.

Hambleton, R. K., Swaminathan, H. y Rogers, H. J. (1991). Fundamentals of Item Response

Theory. E.U.A.: SAGE Publications, Inc.

Mateo, J. y Martínez, F. (2008). Medición y Evaluación Educativa. España: Editorial La

Muralla S.A.

Muñiz, J. (2010). Las teorías de los tests: Teoría Clásica y Teorías de Respuesta a los Ítems.

Papeles del Psícologo, 31(1), 57-66.

Muñiz, J. y Hambleton, R. K. (1992). Medio siglo de teoría de respuesta al ítem. Anuario

de Psicología, 52, 41-66.

¡Opción múltiple…

lo que hay que saber!

Haladyna, Dowing y Rodríguez (2002) proponen una serie de directrices

que deberían de seguirse para la elaboración de Preguntas (o reactivos)

de opción múltiple, llegando a un total de 31 recomendaciones en

aspectos de contenido, formato, estilo, redacción de enunciados y

de las opciones.

Aquí se muestran estas recomendaciones, así

como una serie de ejemplos que pretenden

ilustrar el qué hacer y el qué evitar:

CONTENIDO

1. Cada reactivo debe reflejar el contenido específico y un solo

comportamiento específico, como se pide en las especificaciones

de la prueba.

2. Base cada inciso en algo importante que aprender; Evite el

contenido trivial.

3. Se permite usar materiales nuevos para medir la comprensión y la

aplicación de los conocimientos y habilidades.

4. Mantener el contenido de cada reactivo independiente del

contenido de los demás reactivos de la prueba.

11

• Elaboracion de reactivos recomendaciones*

5. Evitar sobreespecificar y sobregeneralizar contenido al escribir

reactivos de opción múltiple.

6. Evitar los reactivos basados en la opinión.

7. Evitar las preguntas capciosas o engañosas.

8. Mantener un vocabulario sencillo para cada grupo de estudiantes.

FORMATO

9. Usar las tres versiones de las Preguntas de Opción Múltiple (POM):

interrogación, de a completar, la que requiere la mejor respuesta,

opción alternativa (OA), Verdadero Falso (VF), emparejamiento, y la

que depende de contextos. EVITE el formato de POM compleja

(TipoK).

10. Dar formato al elemento vertical en vez de horizontalmente

ESTILO

11. Editar y corregir las preguntas; es recomendable someterla a revisión

con el fin de aumentar su claridad y eliminar errores gramaticales

incluyendo errores de ortografía, puntuación , mayúsculas y

abreviaturas

12. Usar gramática, puntuación, mayúsculas y ortografía correctas

13. Reducir al mínimo la cantidad de palabras en cada pregunta

REDACCION DEL ENUNCIADO

14. Presentar la instrucción lo más claro posible

15. Incluir la idea central en el enunciado en lugar que en las opciones

de respuesta

16. Evitar el escaparitismo (palabrería excesiva)

17. Expresar la oración en positivo, evitando negativos como NO o

EXCEPTO. Si las palabras negativas son utilizadas, ha de ser

cuidadosamente y siempre asegurándose de que la palabra

aparezca en mayúsculas y en negritas

REDACCION DE OPCIONES

18. Evite palabras negativas en el cuerpo de la pregunta

19. Asegurar que solamente una de las opciones sea la respuesta

correcta

20. Variar la locación de las respuestas correctas de acuerdo al número

de opciones

21. Colocar las opciones de una forma lógica u ordenada

22. Mantener las opciones independientes, estas no deben

sobreponerse

23. Procurar que las opciones sean homogéneas en contenido y

estructura gramatical

24. Mantener la homogeneidad en la extensión de las opciones

25. “ninguna de las anteriores” deberá usarse con cuidado

26. Evite “todas las anteriores”

27. Opciones en positivo, evitar opciones en negativo

28. Evitar opciones que den pistas de la respuesta correcta

29. Hacer todos los distractores plausibles

30. Usar errores típicos de los estudiantes, cuando se elaboren los

distractores

31. Si es compatible con el contexto o el profesor, puede usar el humor

Referencias: Haladyna, T. M., Downing, S. M. y Rodríguez, M. C. (2002). A Review of Multiple-Choice Item-Writing

Guidelines for Classroom Assessment. Applied Measurement in Education, 15(3), 309-334. Recuperado el 7 de Febrero de 2012 en: http://www.uam.es/personal_pdi/psicologia/fjabad/PSICOMETRIA/MATERIALES/haladyna_Guidelines_AME_2002.pdf

Roberts, D. M. (1993). An Empirical Study on the Nature of Trick Test Questions. Journal of Educational Measurement, 30, 331-334. Recuperado el 7 de febrero de 2012 en: http://www.personal.psu.edu/users/d/m/dmr/papers/Trick.pdf

^ Haladyna, T. M., Haladyna, R. y Soto Merino, C. (2002). Preparación de Preguntas de Opciones Múltiples para Medir el Aprendizaje de los Estudiantes. OIE-Revista Iberoamericana de Educación. [Versión Electrónica]. Recuperado el 7 de febrero de 2012 en: http://www.rieoei.org/deloslectores/267Haladyna.PDF

La información aquí recabada está basada en una gran

cantidad de bibliografía de apoyo proporcionada dentro del

aula, por lo que no pretende tener una postura rígida ni

determinista al respecto de los temas que aquí se han revisado.

Como se ha mencionado antes, forma parte de herramientas

facilitadoras de la comprensión y el uso de dicha información es

responsabilidad de quien la utiliza.

• Comentarios Finales