Introduccion Procesos Estocasticos Maestria Ingenieria Electronica Opcion Telecomunicaciones

-

Upload

rortegablanco87 -

Category

Documents

-

view

71 -

download

2

Transcript of Introduccion Procesos Estocasticos Maestria Ingenieria Electronica Opcion Telecomunicaciones

UNIVERSIDAD NACIONAL EXPERIMENTAL POLITÉCNICA“ANTONIO JOSÉ DE SUCRE”

VICERRECTORADO BARQUISIMETODIRECCION DE INVESTIGACIÓN Y POSTGRADO

TRABAJO No. 1.(Investigación correspondiente a la Cátedra: Introducción a los Procesos Estocásticos

de la Maestría en Ingeniería Electrónica Opción Telecomunicaciones).

Facilitadora: Participantes:MSc. Marienny Arrieche Héctor, R. Martínez C. I. 18.222.220

Oskar, J. Sánchez C. I. 18.950.734

Barquisimeto, Octubre, 2012

INTRODUCCIÓN

A lo largo de la vida, el ser humano debe tomar decisiones que le

permitan realizar acciones; y estas a su vez implican más y más decisiones;

de tal manera que algunas traen consigo resultados positivos y otras no. Así,

se ha visto en la necesidad de estudiar las probabilidades de ocurrencia de

los eventos para anteponerse a ellos o bien para tomar medidas en función a

esos resultados.

La probabilidad, expresa el grado de certeza y por ende posee un

carácter de seguridad en torno a un suceso aleatorio, cuando es relacionado

con un fenómeno determinístico. De allí que la probabilidad tiene un papel

crucial en la aplicación de la inferencia estadística porque una decisión, cuyo

fundamento se encuentra en la información contenida en una muestra

aleatoria, pudiera tener un error. En este sentido, se presenta el siguiente

informe monográfico, el cual se desarrolla en forma secuencial y organizada

en tres partes:

En la primera, dedicada al estudio de las variables aleatorias, el

proceso de Poisson, la distribución de Poisson, la distribución Gamma y la

distribución Exponencial negativa.

En la segunda, orientada al estudio de la probabilidad condicional para

las variables aleatorias discretas y continuas, en la cual se detallan la formula

de Bayes, la probabilidad y las particiones, el teorema de Bayes, y los

conceptos de probabilidad inicial y final.

Y en la tercera parte, se desarrolla la esperanza condicional para las

variables aleatorias discretas y continuas, cuyos tópicos se centran en las

definiciones de predicción, varianza, momentos, media, mediana, covarianza

y correlación. En cada aspectos se muestran algunos ejemplos orientados a

la practica profesional de la Ingeniería en Telecomunicaciones en el marco

de la tecnología de las radiocomunicaciones aeronáutica y para finalizar se

presentan las conclusiones y referencias bibliográficas y electrónicas que

soportan la presente investigación.

DESARROLLO

1. Variables Aleatorias

El estudio de la probabilidad tiene como finalidad predecir el valor que

pueda tener un evento, bajo ciertas condiciones. Este concepto, está

relacionado con la calidad en la producción bien sea de bienes o servicios,,

dado a que se pueden comprender y controlar datos y de allí hacer

conclusiones e inclusive aplicar correctivos y disminuir tendencias negativas;

o bien tomar medidas preventivas. Es por ello que este estudio, permite

confiar en la probabilidad de que un evento suceda o no.

Tanto así que, existen procesos que poseen un carácter variable y de

aleatoriedad; como el clima por citar un ejemplo. De allí que combinando

estos aspectos, las variables aleatorias son definidas por Walpole, R. Myers,

R. y Myers, S. (1999) como: “una función que asocia un número real con

cada elemento del espacio muestral” (p. 51).

La definición anterior, se relaciona al espacio muestral, es decir a los

diversos resultados que puede tener un determinado experimento, que

ciertamente está asociado a condiciones no controladas e inclusive al azar.

Este tipo de variables permite entonces convertir el resultado de un

experimento en una forma numérica, y se utiliza particularmente cuando el

investigador se centra en un aspecto específico del mismo, es decir en una

muestra.

Para ejemplificar una variable aleatoria se puede tomar en

consideración una situación en la que un estudiante de postgrado de la

UNEXPO intenta estacionar su vehículo en el estacionamiento de la misma.

Entonces puede conseguir un lugar para estacionarse (P) y hacerlo, o no

encontrar sitio (N) y tener que salir del mismo. Con S = {P, N} la variable

aleatoria (X) se puede definir mediante X (P) = 1, X (N) = 0. De manera que

1 indica que pudo estacionarse y 0 que no lo logró. Cabe acotar, que las

variables cuyos únicos valores que puede tomar son 1 y 0 se conocen como

variables de Bernoulli; no obstante en un sentido general se pueden clasificar

las variables aleatorias en dos tipos: continuas y discretas.

Devore, J (2005) refiere que: “una variable aleatoria discreta es una

variable aleatoria cuyos valores posibles constituyen un conjunto finito…//

una variable aleatoria es continua si su subconjunto de valores posibles

consiste en un intervalo completo en la recta numérica” (p. 100). Es decir

que una variable aleatoria es discreta cuando puede tomar valores que se

pueden contabilizar e incluso arreglar en forma secuencial, mientras que una

variable aleatoria es continua si sus valores consisten en intervalos

referenciados en la recta de los números reales.

En resumen, en el estudio probabilístico de cierto experimento se

pueden considerar variables aleatorias para generalizar sus resultados

posibles, y trabajar con las mismas sin tomar en consideración cual será el

resultado final. Evidentemente, esta variable pertenece al conjunto del

espacio muestral y puede ser un valor numérico, booleano, texto, etc. No

obstante, se suele trabajar con los valores numéricos porque son los que

aportan mayor cantidad de información al momento de medir magnitudes, o

incluso realizar operaciones para establecer conclusiones de los resultados

arrojados por dicho experimento.

Es importante destacar, que cuando un experimento arroja resultados

textuales, o booleanos se establecen parámetros de codificación para

transformar a forma numérica los elementos del espacio muestral. Por

ejemplo, si se realizase un experimento en el que se observara ¿cuál es la

rama de la ingeniería a la que pertenece el participante de la “Maestría en

Ingeniería Electrónica Opción Telecomunicaciones” que entra primero al aula

de clases?, el espacio muestral viniera dado por las ramas de la ingeniería

que poseen cada uno de los estudiantes de dicho programa, ejemplo:

Y la codificación sería algo como:

S = {Electrónica, Eléctrica, Sistemas, Telecomunicaciones}

S = {1: Electrónica, 2: Eléctrica, 3: Sistemas, 4: Telecomunicaciones}

Nótese, que en el ejemplo anterior la variable aleatoria (X) viene

determinada por la persona que entre primero al aula de clases (y la rama de

la ingeniería a la que pertenece); y el experimento en general es disjunto ya

que no van a entrar dos personas en forma simultanea.

Para el caso especifico de las variables aleatorias discretas, estas

pueden tomar valores que son numerables, lo que da un carácter de

posibilidad en cada punto aislado del espacio muestral; por ende hay una

cantidad finita de valores posibles entre los resultados que puede arrojar un

experimento. Por lo que en función a este tipo de variables aleatorias, se

realizaron estudios de distribución que permiten agrupar el conjunto de

valores posibles y relacionar a los mismos con sus respectivas

probabilidades de ocurrencia.

1.1 Distribución y Proceso de Poisson

Particularmente, el proceso de Poisson toma en cuenta un continuo en

el cual ocurren los eventos; de manera que se establece una relación entre

estos dos aspectos.

Por ejemplo: si se evalúan la cantidad de fallas de un sistema

cualquiera en 5 horas, el continuo sería el tiempo y los eventos serian las

fallas que ocurren. La referencia al continuo no necesariamente está ligada al

tiempo, tal que si se toma en consideración una rollo de cinta para

impresoras y se cuentan los tramos en los que el rollo no posee tinta, el

continuo sería la longitud de cinta que posee el rollo y los eventos la cantidad

de tramos sin tinta.

En este orden de ideas, el proceso de Poisson toma en cuenta 3

variables a saber:

T: representa la longitud de un intervalo del continuo que va a estudiarse

K: representa la cantidad de eventos en ese intervalo:

: representa la cantidad esperada de eventos por unidad de tiempo.

Estas 3 variables pueden observarse en el siguiente ejemplo: Si se

considera un equipo de Radio Ayudas (DVOR) el cual falla 2 veces cada una

hora, y se evalúa dicho evento durante 5 horas (desde las 13:00 hasta las

18:00), en los que falla 11 veces. Las variables serían vistas como:

De tal manera que, conocidas las cantidades de eventos que se

registran en la evaluación () podría cuestionarse acerca de la cantidad de

eventos en un determinado tiempo, o bien el tiempo que hay que esperar

hasta observar una cantidad de eventos. De este planteamiento surgen 3

distribuciones de probabilidad a estudiar en la presente investigación: a)

distribución de Poisson: en la cual se considera la cantidad de eventos en el

periodo de evaluación – el continuo, b) distribución Gamma en la cual se

determina la cantidad de tiempo necesario hasta observar cierta cantidad de

eventos, c) distribución exponencial negativa, que es una derivación de la

distribución Gamma y se determina la cantidad de tiempo para observar el

primer evento.

El proceso de Poisson se caracteriza por ser estacionario,

independiente en el número de resultados que suceden en un intervalo de

tiempo o región del espacio y simple. De manera que, de acuerdo a este

proceso la probabilidad de que ocurra un solo resultado durante un intervalo

de tiempo muy corto o en una región pequeña es proporcional al propio valor

tomado como referencia (bien sea de tiempo o región); mientras que la

probabilidad de que ocurra mas de un resultado en tal intervalo corto o que

caiga en tal región es prácticamente insignificante.

En referencia a la distribución de Poisson, se utiliza cuando existe un

determinado intervalo en el que suceden eventos y se necesita calcular la

T = 5 horas “el continuo – tiempo de evaluación”

K= 11 eventos “cantidad de fallas registradas”

= 2 eventos/hora “cantidad de eventos por horas”

cantidad de éstos en dicho intervalo, de manera que para utilizar esta

distribución se toma en consideración un parámetro denominado Media, que

no es más que una tendencia estadística. Sus aplicaciones se evidencian

con frecuencia en el control de calidad, la garantía de la calidad, el muestreo

e incluso para estudios de confiabilidad.

Para estudiar esta distribución, se puede tomar como referencia la

situación en la que un equipo falla 12 veces por hora, y es evaluado durante

15 minutos. Entonces el valor de la media viene dado por la relación:

= De tal manera que, se puede definir la variable aleatoria de Poisson

como:

= ( )La cual es una variable con media µ, y en donde X representa la

cantidad de eventos obtenidos en un intervalo de longitud T e intensidad: .

De allí que:

( = ) = − !Entonces, para el ejemplo anterior la media es igual a:

= 12 fallas/horas x 15 minutos = 12 fallas/60 minutos x 15 minutos

= 3 fallas.

Si se quiere determinar la probabilidad de que el equipo no falle en

esos 15 minutos sería

( = 0) = 3 ! = 0.04979

O bien, si se quiere determinar la probabilidad de que falle 4 veces en

ese tiempo:

( = 4) = 3 ! = 0.1680

Es de notar, que el valor de la media, siempre es positivo, y que al

sumar la probabilidad para todos los eventos que se pueden dar en un

experimento, el resultado debe ser igual a 1; esta regla es el fundamento de

la suma de probabilidades de Poisson que matemáticamente se representa

como:

( , )∞

= 1Formula que se resume con:

− !∞

= 1Con el ejemplo anterior se puede entonces realizar un histograma con

las probabilidades de eventos, tal como se muestra a continuación:

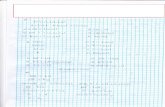

Cuadro 1

Tabla de Valores para Distribución de Poisson de un equipo que falla 12

veces por hora y es evaluado durante 15 minutos.

( = )Fallas Probabilidad

0 0,04981 0,14942 0,22403 0,22404 0,16805 0,10086 0,05047 0,02168 0,00819 0,0027

10 0,000811 0,000212 0,0001

∑ = 1,0000

Los autores (2012)

Gráfico 1.

En el cuadro 1 se observa la tabla de valores que se origina al evaluar

hasta un máximo de 12 fallas con la distribución de Poisson. En el gráfico 1

se puede observar que entre 2 y 3 fallas la curva gaussiana toma un valor

máximo de probabilidades de eventos a ocurrir en el tiempo evaluado.

Es de notar que en este proceso de Poisson se pueden observar

eventos discretos en un área de oportunidad, que al acortarse acorta las

posibilidades de suceso y permite observar estabilidad en la gráfica.

1.2 Distribución Gamma

Para definir la Distribución Gamma es preciso conocer a que se refiere

la función Gamma, la cual viene determinada con la relación:

Γ( ) = − −∞

La cual es valida para valores positivos de " ", y cuyo resultado al

integrar por partes, para valores mayores que uno, son Γ( ) = ( 1) ∙

-3.89E-16

0.05

0.1

0.15

0.2

0.25

0.3

0 1 2 3 4 5 6 7 8 9 10 11 12

Dis

trib

uci

òn

de

Po

isso

n

Eventos (Fallas)

P (X = x) Probabilidad

Los autores (2012)

Γ( 1); para cualquier entero positivo " ", el valor de Γ( ) = ( 1)!. Mientras que para Γ 2 = √

Las distribuciones Exponencial y Gamma tienen una amplia gama de

usos en lo que respecta a la teoría de colas y en la resolución de problemas

de confiabilidad, y permiten determinar la probabilidad de tener que esperar

un determinado tiempo hasta que suceda un primer evento o un número

determinado de eventos, respectivamente.

Evidentemente, la distribución Gamma, trabaja con una variable

aleatoria, la cuales viene representada por el tiempo que debe transcurrir

antes de que sucedan los eventos, de manera que la densidad de

probabilidad de esa variable viene dada por la relación matemática

( ; , ) = 1Γ( ) − exp ( ) x>0, a, θ>00 para cualquier otro valor

�Donde es el tiempo promedio entre dos eventos sucesivos y su

inverso (1/ ) se entiende como la frencuencia constante de ocurrencia.

Esta distribución es muy variada puesto que dependiendo del valor del

parámetro " " pueden suceder varios escenarios. En la siguiente tabla se

muestran las propiedades de la distribución Gamma:

La distribución Gamma (o también conocida como la distribución de

Erlang), se relaciona con la distribución de Poisson, tal que la probabilidad de

Fuente: Canavos, G. (1988)

que el tiempo que transcurre hasta el “ -ésimo” evento exceda el valor de

" " es igual a la probabilidad de que el numero de eventos de Poisson " "observados en no sea mayor que ( 1)”. De tal manera que:

“La distribución de Erlang es el modelo para el tiempo de espera hasta que ocurre el a-ésimo evento de Poisson, y la distribución de Poisson es el modelo para el numero de eventos independientes que ocurren en un tiempo x, encontrándose éste distribuido de acuerdo al modelo de Erlang” (et.al. p.152)

De allí que, al determinar la distribución Gamma, incluso se pueden

utilizar modelos matemáticos similares a los utilizados con la distribución de

Poisson. Cabe destacar, que el análisis matemático de esta distribución es

complejo, dada su dificultad para la integración; en tanto una forma

alternativa de determinarla podría ser considerando que la probabilidad de

que el tiempo que se tarda en obtener el evento esperado ( -ésimo) sea

menor que , es igual a la probabilidad de que en un intervalo de duración

existan " "o mas eventos. En este sentido, se tiene que ( ) = 1( 1) donde " " es la variable aleatoria Gamma, la cual posee los

parámetros , y ; en tanto que Y es una variable de Poisson cuyo = ∙ ,

con lo que se puede sustituir la integral por:

∫ ( ) = 1 ∑ ( = ).

Y se puede resumir la distribución Gamma como:

( ) = ( ) − −( 1)!

Es importante destacar, que la distribución Gamma se utiliza cuando

se describe el continuo temporal en el cual suceden los eventos, y se

continúa la observación de los mismos hasta que suceda una cantidad de

eventos determinada; asimismo, se utiliza cuando se conoce o puede

determinar la frecuencia promedio con la que suceden los eventos .

Entre las características que determinan esta definición se tiene que:

a) no es nula para todos los tiempos mayores a cero, ya que es imposible

tener que esperar un tiempo negativo hasta que sucedan eventos; b) no es

conveniente para tiempos muy grandes, ya que hace despreciable su uso; c)

todos los eventos involucrados deben ser independientes (como corresponde

a los Procesos de Poisson).

Para ejemplificar la distribución Gamma, se puede considerar una

situación en la que un equipo de transferencia de datos, transmita 50

mensajes durante un día. Si su tasa de transmisión es de 4 mensajes por

hora. Entonces, que probabilidad habría de transmitir todos los mensajes en

12 horas.

Tomando en consideración que cada mensaje es independiente, es

decir que no son correlativos, ni se relacionan con otros, se establece el

ejemplo como un Proceso de Poisson, cuya variable Gamma viene dada por

el tiempo que puede tomar transmitir los 50 mensajes, con = 4 y

= 50 . Por lo que la variable aleatoria Gamma se puede representar

como: = ( = 4; = 50), para t > 0.

En este sentido, la distribución Gamma viene dada por:

( ) = 4(4 ) − −(50 1)! = 16 −

6.08 ∙ 10 2 = .6904 ∙ 10− ( − )Entonces para que tarde menos de 12 horas, se debe solucionar la

integral Gamma, la cual queda expresada a continuación.

( < 1 ) = ( ) = .6904 ∙ 10− ( − )2∞−∞= .6904 ∙ 10− ( − )2

= .6904 ∙ 10− 1 − ( 2)(1 + 4)= .6904 ∙ 10−

Lo cual se representa una probabilidad bastante ínfima y que se hace

obvia dada la velocidad de los sistemas de transmisión digital.

1.3 Distribución Exponencial

Como se mencionó anteriormente, la distribución exponencial

(negativa) es una variante de la Distribución Gamma, en la que la variable

aleatoria exponencial es el tiempo que trascurre hasta que se presenta el

primer evento de Poisson; de manera que, permite realizar un modelo entre

el intervalo en el que se presentan dos eventos consecutivos, como por

ejemplo las primeras dos muestras que se toman referenciados a cierto valor

de amplitud en una señal continua. Cabe destacar, que estos eventos se

caracterizan por ser independientes y a una frecuencia constante. Canavos,

G. (1988), refiere que “esta distribución se emplea con bastante frecuencia

con objeto de modelar problemas del tipo tiempo-falla y como modelo para el

intervalo en problemas de línea de espera” (pp. 163).

La referencia a la aplicación del precitado autor, permite analizar que

esta distribución no posee un carácter recordatorio, en lo que respecta a la

probabilidad de que el evento analizado ya se halla presentado o se presente

en el futuro, lo cual limita su carácter predictivo; solo se limita a la

probabilidad de que una unidad falle en un periodo específico de tiempo.

En líneas generales, una situación que requiera ser análizada

mediante esta distribución describe el continuo temporal en el cual suceden

los eventos, indica que observación hasta la ocurrencia del primer evento

(mientras), permite determinar la frecuencia promedio de ocurrencia de

eventos “ ”, y se enfoca en la determinación de la probabilidad de suceso

referencia en el tiempo.

Matemàticamente, una variable aleatoria continua “X” posee una

distribución exponencial, con parámetro “ ”, si su función de densidad se da

por la relación:

( ) = 1 −0

� > 0

En esta relación se identifica el parámetro “ ” que representa el lapso

promedio de tiempo entre dos eventos de Poisson.

Un ejemplo practico de esta distribución podria ser un sistema

cualquiera, el cual ha sido recientemente reparado y se prevé observar su

comportamiento, luego de esa reparación, en función de verificar si falla

nuevamente. Suponiento la variable aleatoria T, con tiempo medio para la

falla “ ” = 5. Si se observan las 5 etapas de este sistema, ¿Cual sería la

probabilidad de que al menos 2 etapas funcionen al final de la semana (8

días)?. En este orden de ideas, la probabilidad de que una sola etapa

funcione se modela exponencialmente a través de la relación:

( > 8) = 15− = − ≈ 0.∞

2. Probabilidad Condicional para variables discretas y

continuas

La probabilidad condicional consiste en realizar un experimento, cuyo

espacio muestral de posibles resultados es S, sin embargo su estudio se

caracteriza por incluir datos adicionales que especifican las probabilidades

para todos los eventos o sucesos de S, es decir que se puede realizar un

estudio más detallado de la forma como cambia la probabilidad de un suceso

cuando se sabe que otro evento ha ocurrido y que efecto puede generar este

en la misma.

En tal sentido, citando a autores como Morris, D. (1986) “denomina la

probabilidad condicional del suceso A dado que el suceso B ha ocurrido” (p.

55).

Siguiendo el mismo tenor de ideas, Murray, S. (1976) establece que,

“llamamos a P (B|A) la probabilidad condicional de B dada A, es decir la

probabilidad de que B ocurra dado que A ha ocurrido” (p. 55).

Para Walpole, R. Myers, R. y Myers, S. (1999), “la probabilidad de

que un evento B ocurra cuando se sabe que ya ocurrió algún evento A se

llama probabilidad condicional y se denota por P (B|A)” (p. 35).

Se puede considerar que las tres definiciones coinciden en sus

términos y es importante destacar que al conocer que un evento ha ocurrido,

se convierte en el nuevo espacio muestral reemplazando el original y a su

vez desde el punto de vista frecuencialista, la probabilidad condicional tiene

una interpretación sencilla, en efecto, de acuerdo con esa apreciación, si un

proceso experimental se repite muchas veces, se puede deducir que la

proporción de repeticiones en las cuales el suceso B ha ocurrido es

aproximadamente ( ) y la proporción de repeticiones en las cuales el

evento A y B ocurren es aproximadamente ( | ). Por tanto, entre las

repeticiones que en el suceso B ocurre, la proporción de repeticiones en que

también ocurre el suceso A, de esta manera se define así:

( | ) = ( ) ( )Por otra parte, Devore, J (2005) argumenta que “para dos eventos

cualesquiera A y B con P (B) > 0, la probabilidad condicional de A dado que

ocurrió B se define mediante la ecuación” (p. 77):

( | ) = ( ∩ ) ( )Finalmente la ecuación nos indica que matemáticamente si ambos

eventos cualesquiera ( ) > y la probabilidad ( | ) no está

especificada si ( | ) = .

Figura 1. Diagrama de Venn para la probabilidad condicional

Fuente: Morris, D. (1985)

Como ilustra el diagrama de Venn ( | ) mide en cierto sentido la

probabilidad relativa de A con respecto al espacio reducido B. En pocas

palabras quiere decir que la probabilidad condicional toma en cuenta

información sobre la ocurrencia de un evento para predecir la probabilidad de

otro.

2.1 Probabilidad y particiones

Harris estipula que, “sea S el espacio muestra1 de un experimento y

considérense K sucesos , … . , de S de forma que , … . , sean

disjuntos y ⋃ = .. Se dice que estos sucesos constituyen una

partición de S. Si los b sucesos , … . , constituyen una partición de S y si

B es cualquier otro suceso en S, entonces los sucesos Al B, A2 B, . . . , Ak B

constituyen una partición de B, como se ilustra en la siguiente figura. Se dice

que estos sucesos constituyen una partición de S.

Figura 2. Intersecciones de B con los sucesos de A1,…A5 de una partición

Si los k sucesos , … . , constituyn una partición de S y si B es

cualquier otro suceso en S, entonces los sucesos , 2 , … , ,

constituyen una partición de B. De esta manera se expresa la siguiente

ecuación:

Fuente: Morris, D. (1985)

Pr( ) = Pr Pr ( | )Después de analizar minuciosamente, se puede considerar que la

probabilidad de una partición consiste en dividir el espacio muestral en varios

eventos mutuamente excluyentes y descomponerlo en función de un evento

que tenga componentes en dicho espacio muestral.

Para comprender mejor la teoría supóngase que un radar primario de

vigilancia tiene un área de cobertura de 40 NM y que para cierto momento

detecta 5 aeronaves legales y 2 ilegales al noreste, en ese mismo instante

percibe 3 aeronaves legales y 1 ilegal al noroeste, a su vez detecta al sureste

4 legales y una ilegal y de igual manera tiene 2 legales y 1 ilegal al suroeste.

Supóngase también que selecciona una aeronave de forma aleatoria (las

aeronaves no tienen identificación). ¿Cuál es la probabilidad que la aeronave

seleccionada sea ilegal?

Sea A1 el evento de que selecciones el noreste, sea A2 el evento de

que seleccione el noroeste, sea A3 de que seleccione el sureste, sea A4 de

que seleccione el suroeste y sea B el evento de que seleccione la aeronave

ilegal.

Entonces:

Pr( ) = Pr( 1) Pr( | 1) + Pr( ) Pr( | ) + Pr( ) Pr( | ) + Pr( 4) Pr( | 4)Puesto a que selecciona una dirección al azar se sabe que Pr( ) =

Pr( 2) = Pr( ) = Pr( ) =Además la probabilidad de seleccionar una aeronave ilegal en la

primera dirección viene dada por:

Pr( | ) = 2

La probabilidad de seleccionar la segunda dirección es: Pr( | 2) =La probabilidad de seleccionar la tercera dirección es: Pr( | ) = 2

La probabilidad de seleccionar la cuarta dirección es: Pr( | ) = 2

Sustituyendo en la ecuación se obtiene que la probabilidad de

seleccionar una aeronave ilegal es:

Pr( ) = 0. 9

2.2 Teorema de Bayes

Supóngase que los sucesos , … . , constituyen una partición del

espacio S tal que Pr(Aj) > O para j = 1, . . . , k y sea B cualquier suceso tal

que Pr(B) > O. Entonces, para i = 1,. . . , k.

Pr( ∣ ) = Pr( ) Pr ( | )∑ Pr( ) Pr ( | )Es importante destacar que el teorema de Bayes proporciona una

regla sencilla para calcular la probabilidad condicional de cada suceso Ai

dado B a partir de las probabilidades condicionales de B dado cada uno de

los sucesos Ai y la probabilidad incondicional de cada Ai.

Para una mejor compresión, de los antes dicho se tomaran los datos

del ejemplo anterior para determinar la probabilidad de que la aeronave

seleccionada sea legal, para ello se tienen , 2, . Y se determinara la

probabilidad de que la dirección seleccionada haya sido , Donde:

= 6% = 0. 6, 2 = 15% = 0.15, = 1% = 0. 1, = 5% =0.05

La probabilidad de que selecciones a uno de los eventos es:

Pr( ) = Pr( 2) = Pr( ) = Pr( ) = 14 Además la probabilidad de seleccionar una aeronave legal en la

primera dirección viene dada por:

Pr( | ) =La probabilidad de seleccionar la segunda dirección es: Pr( | 2) =La probabilidad de seleccionar la tercera dirección es: Pr( | ) =La probabilidad de seleccionar la cuarta dirección es: Pr( | ) = 2

Sustituyendo en el teorema de Bayes:

Pr( ∣ ) = Pr( ) Pr ( | )∑ Pr( ) Pr ( | )Pr( ∣ ) = 0.66 ∗ 0. 5∑ (0. 5 ∗ 0.71) + (0. 5 ∗ 0.74) + (0. 5 ∗ 0.66) + (0. 5 ∗ 0.5)

2.3 Probabilidad inicial y probabilidad final

Una probabilidad como Pr(A ) se denomina usualmente probabilidad

inicial de que la aeronave seleccionado haya sido legal y este en la dirección

sureste, debido a que Pr(A ) es la probabilidad de este suceso, antes de que

la aeronave sea seleccionado y antes de que se sepa si la misma es legal o

ilegal. Una probabilidad como Pr(A ∣ B) se denomina entonces la

probabilidad final de que el artículo seleccionado haya este en la dirección

sureste, debido a que es la probabilidad de este suceso después de saber

que el artículo seleccionado es legal.

En pocas palabras la probabilidad inicial es la probabilidad de un

suceso determinado sin estar condicionado a la ocurrencia previa de otro

evento y la Probabilidad final es la probabilidad de un suceso determinado el

cual está condicionado a la ocurrencia previa de otro evento.

3. Esperanza condicional para variables discretas y continuas

Antes de definir la esperanza condicional aplicada a las variables

discretas y continuas, es preciso considerar la esperanza matemática en

sentido general. Se refiere al valor que se podría esperar que asuma una

variable aleatoria si se realiza un experimento al cual está asociada.

Evidentemente, que el precitado concepto se asocia a las variables aleatorias

continuas y discretas, tal que se considera la sumatoria de las probabilidades

del espacio muestral para las variables discretas y la integración de la

función cuando es continua.

La esperanza o valor esperado constituye así, un concepto de gran

relevancia en el estudio de las distribuciones de probabilidad, ya que permite

determinar un valor promedio que puede aumentar o disminuir después de

un número muy grande de repeticiones del experimento. De allí se puede

inferir que la esperanza condicional permite obtener una idea del valor que se

puede esperar al realizar un experimento, y que una vez obtenidos los

resultados del mismo, permite tener una distribución de probabilidades para

otra variable.

Si de determina la distribución condicional de X dado Y, entonces la

probabilidad condicional depende de “x” y de “y”, de tal manera que permite

obtener una distribución para X, al conocer el valor de Y; es decir que para

cualquier valor valido de “y”, / ( , ) es una distribución perfectamente

valida para “x”.

Un ejemplo de la esperanza matemática podría ser, si dentro de un

lote de equipos hay 7 componentes (circuitos integrados), y de éstos se

sabe que 4 están en óptimas condiciones y 3 están defectuosos. Entonces si

se toma una muestra de 3 componentes, al azar, se puede determinar la

esperanza de componentes buenos en esa muestra al efectuar, la

combinación

( ) =4

7 , = 0,1, ,Esa relación se toma en cuenta, considerando que en la muestra

seleccionada pueden haber 0, 1, 2, ó 3 componentes, buenos entonces la

distribución de probabilidad para esos casos daría

(0) = 15 , (1) = 15 , ( ) = 185 , ( ) = 45Entonces, al aplicar el principio de la esperanza matemática se

tendría que:

( ) = (0) 15 + (1) 15 + ( ) 185 + 45 = 17 = 1.7

Que representa el promedio de componentes buenos.

La determinación de la esperanza matemática varía, en relación a si

es la variable aleatoria es discreta o continua. Walpole, R. Myers, R. y Myers,

S. (1999), identifican que “el valor esperado de una variable aleatoria ( ) es

( ) = [ ( )] = ∑ ( ) ( ) si X es discreta, y ( ) = [ ( )] =∫ ( ) ( ) si X es continua” (pp. 88).

3.1 Propiedades básicas

El autor Morris, D. (1986) en su texto Probabilidad y Estadística,

refiere que la Esperanza Matemática, presente algunas propiedades

características; las cuales se presentan a continuación:

Teorema 1. Si = + , donde “ ” y “ ” son constantes, entonces

( ) = ( ) + . Este teorema, se corresponde a la estimación del valor

esperado de una función lineal, que bien pudiera ser discreta. Su

demostración consiste en comprender que “ ” como variable aleatoria, posee

una función de densidad de probabilidad, que puede incrementar o no, en

función a un valor constante.

Teorema 2. Si existe una constante “ ” tal que Pr( ≥ ) = 1,

entonces ( ) ≥ ; mientras que si la constante es “ ”, para Pr( ≤ ) = 1,

entonces ( ) ≤ .

Teorema 3. Si , 2, … , son “ ” variables aleatorias cuyas

esperanzas ( ) ( = 1, , … ) existen, entonces ( + 2 + ⋯ + ) =( ) + ( 2) + ⋯ + ( ). Es decir que, es posible determinar la esperanza

en una sumatoria de variables, la cual será resultante a la suma de sus

esperanzas individuales en forma independiente.

3.2 Predicción

La predicción es un término que está asociado a la probabilidad “p” de

una evento E, cualquiera, el cual indica que en un numero elevado de

experimentos el evento E ocurrida en una proporción “p”. Es importante

destacar, que las predicciones se hacen sobre eventos de los que se

desconoce su ocurrencia, bien sea de forma aleatoria o continua (en un

momento dado o en forma acumulada), en una sucesión de momentos.

En general, este concepto esta asociado al azar, dado a que

representa el basamento para poder predecir, y requiere de la consideración

de todas las características que describen el evento en estudio. Interpretando

a Barboianu, C. y Martilotti, R (2009), la predicción tiene un carácter

ontológico, es decir que se basa en el hecho y en sus propiedades.

Un ejemplo, de la predicción podría ser el principio de funcionamiento

de un radar primario, el cual detecta blancos móviles y fijos tras una cantidad

de barridos. En este orden de ideas, toma en consideración las condiciones

de movimiento de los blancos para establecer la dirección y sentido del

movimiento de los blancos.

Entonces, si consideramos la ocurrencia de un evento E, “n” veces, se

puede concluir que E ocurrirá también en la “n+1” vez, lo que aplicado a la

propiedad frecuencialista implica que al evaluar la frecuencia , 2, … que

son aproximadamente iguales n veces, entonces los resultados seguirán

siendo los mismos en la frecuencia siguiente de en la observación “n+1”.

La afirmación anterior, se basa en la suposición tácita que la realidad

es predecible, o dicho de forma probabilística, de que existe un límite de la

frecuencia.

3.3 Varianza

Dado que la esperanza matemática permite tener una idea acerca del

valor que se puede esperar una determinada variable aleatoria, dentro de un

experimento cualquiera; permite referenciar un posición dentro del espacio

muestral. Asimismo, permite conocer si los valores que puede tomar la

variable aleatoria están cercanos o lejanos, lo cual conlleva a establecer una

tendencia de acercamiento o alejamiento de los valores que puede tomar la

variable aleatoria con relación a la media; este aspecto es el objeto de la

varianza. La varianza es una medida de cuanto tienden los valores de una

variable aleatoria a alejarse de la media de la misma, por lo tanto es una

medida de dispersión. Es por ello que Anderson, D. y Sweeney, J (2008)

refieren que “la varianza brinda una información importante para tomar un

decisión” (p. 435)

Para determinar la varianza de una variable aleatoria X, se aplica:

( ) = 2 = (( ( ))2 = ( )2 ( )∞

−∞La varianza, se define entonces como la esperanza de los cuadrados

de las distancias entre los valores de la variable y el valor medio de la

distribución. Cabe destacar, que la dispersión entre los valores de la variable

aleatoria, entonces el valor esperado tenderá a ser más grande y por ende la

varianza tendrá tendencia a ser mayor.

Al operar, la ecuación anterior resulta

2 = ∑( ̅)21

Una aplicación podría ser , si se desea calcular la varianza al

considerar un historial de fallas. Se toma una muestra temporal, supongamos

4 meses, en los que la cantidad de fallas fueron (12, 15, 17, y 20). Entonces

se determina el promedio de fallas de esos 4 meses (16 fallas), por tanto la

varianza se puede calcular de la siguiente manera:

2 = ∑( − ̅)− = ∑( − )

− = ( 2− ) ( − ) ( − ) (2 − ) =

3.4 Momentos

Los momentos de una variable aleatoria “X” son los valores esperados

de ciertas funciones de la misma. Estos representan una colección de

medidas descriptivas que permiten caracterizar la distribución de probabilidad

de la variable y especificarla si todos los momentos son conocidos. Su

definición se presenta alrededor de un punto de referencia, que

generalmente es el cero o bien de la esperanza de X.

En este sentido, tomando en consideración el n-ésimo momento de la

variable alrededor del cero, se puede definir como: ′ = ( ) = ∑ ( )Para las variables aleatorias discretas, y ′ = ( ) = ∫ ( ) Para las

variables continuas.

Es importante destacar, que el primer momento alrededor del cero es

la media o valor esperado de la variable aleatoria y se denota por ; de esta

manera se tiene que = = ( ); mientras que la varianza es el segundo

momento alrededor del origen menos el cuadrado de la media.

3.5 La media y la mediana

La media de una distribución de probabilidad es un parámetro que se

ubica en el centro de gravedad de esa distribución. En este sentido, la media

de una distribución es considerada como el centro de la distribución, es decir

un punto que divide la probabilidad total en dos partes iguales ( ) tal que

tanto a la izquierda como a la derecha de este valor es equivalente a 0.5;

este punto es denominado mediana de la distribución. Es importante resaltar,

que para algunas distribuciones discretas, no existirá algún punto en el que la

probabilidad sea dividida en dos partes iguales.

Por otra parte, para otras distribuciones (discretas o continuas),

existirán mas de tales puntos por lo tanto la definición de la mediana debe

incluir esas posibilidades.

Para cualquier variable aleatoria S, una mediana de la distribución de

X se define como un punto μ tal que. Pr(x ≤ μ ≤ 0.5) y Pr (x ≥ nz) ≥ 0.5En otras palabras, una mediana es un punto nz tal que satisface los

dos requisitos siguientes: En primer lugar, si μ está incluida en los valores de

X a la izquierda de “μ” entonces Pr(X ≤ μ) ≥ Pr(X > μ); y en segundo lugar,

si μ se incluye en los valores de la variable aleatoria X, a la derecha de μentonces. Pr(X ≥ μ) ≥ Pr(X < μ).

3.6 Covarianza y correlación.

3.6.1 Covarianza

Si se consideran variables conjuntas de dos variables aleatorias,

en conjunto con las medias, mediana y varianzas seguramente van a

proporcionar información importante de sus distribuciones. No obstante es

datos no indican información acerca de su tendencia a variar junas y no

de forma independiente; lo que quiere decir que se estudiara nuevos

parámetros que permiten medir la asociación entre dos variables

aleatorias y predecir el valor independiente de una de ellas de forma

independiente utilizando el valor observado de otra la variable

relacionada.

Por lo tanto, sean e variables aleatorias que tienen una

distribución conjunta cuyos primeros momentos y varianzas son ( ) = , ( ) = , ( ) = 2 = 2 la covarianza e , que se denota

por ( , ) se define de la siguiente manera:

( , ) = [( )( )

3.6.2 Correlación

Si 0 < 2 < < 2 < , entonces la correlación de e que se

denota ( , ), se define como sigue:

( , ) = ( , )

Para determinar el rango de valores posibles de la correlación ( , ),

es necesario el siguiente resultado:

[ ( )]2 ≤ ( 2) ( 2)

CONCLUSIONES

Una vez examinada, procesada y analizada la información recabada

en los diferentes libros de textos, los cuales profundizaron los conocimientos

y la adquisición de los mismos para aplicar, analizar y utilizar conceptos

formales basados en variables aleatorias, en la probabilidad condicional y en

la esperanza para variables discretas y continuas; es importante rescatar de

dicho estudio, el análisis de métodos probabilísticos para la evaluación de

problemas cotidianos o aquellos intrínsecos en campos de de la ingeniería

como la electrónica y las telecomunicaciones, donde se presentan variables

aleatorias, discretas y continuas que afectan el desempeño de sistemas de

comunicaciones que seguramente serán optimizados en función de la

aplicación de las herramientas probabilísticas heredadas de este informe.

Seguidamente, cabe destacar que se estableció como y cuando

diferenciar nociones probabilísticas elementales como la frecuencialista

(objetiva) fundamentada en la frecuencia relativa de las veces que ocurrirá un

proceso al realizar un experimento repetidas veces; de aquella probabilidad

bayesiana (subjetiva) basada en la certeza que se posee sobre un evento.

De esta manera, la probabilidad se adelanta a los hechos, es decir

que puede resultar predictiva considerando un estudio ontológico detallado

de todas las propiedades intrínsecas en el universo del espacio muestral,

aunado a esto con el pasar del tiempo y de muchas repeticiones de los

experimentos puede adicionar datos estadísticos que a la larga pueden

otorgar una mayor comprensión de los sistemas y de nuestro entorno.

Finalmente, se puede afirmar, desde un punto de vista filosófico, la

característica particular que tiene la vida, su entorno, el universo entero en

ser a lo largo de ellos totalmente aleatorios, condicionados y variables

discretas y continúas.

REFERENCIAS

Anderson, D. y Sweeney, D. (2008). Estadística para administración y

economía, decima edición, Cengage Learning Editores, México.

Barboianu, C. y Martilotti, R. (2009). “Entendiendo las Probabilidades y

Calculándolas” Infarom, Rumania.

Berenson, M. y Levine, D. (1996). Estadística básica en administración.

Conceptos y Aplicaciones. Editorial Pearson, México.

Canavos, G. (1988) “Probabilidad y Estadística, aplicaciones y métodos”,

Mc.Graw-Hill, México.

Devore, J. (2005) “Probabilidad y Estadística para ingeniería y ciencias”,

Sexta Edición, Thomsom, México.

Fernández, S, Cordero, J, y Córdoba A. “Estadística descriptiva”, Segunda

edición, ESIC, España.

Gmurman, V. (1974). “Teoría de las Probabilidades y Estadística

Matemática”, Moscú Editorial, URSS.

Zylberberg, A. (2006). “Probabilidad y Estadística”, Nueva Librería, Argentina.

Levin, R. y Rubin, D. (2004). Estadística para administración y economía.

7ma edición, editorial Pearson, México.

Morris, D. (1988). “Probabilidad y Estadística” Addison-Wesley

Iberoamericana, Estados Unidos.

Murray, S (1976) “Probabilidad y Estadística: teoría y 760 problemas

resueltos”. Serie de Compendios SCHAUM, Mc.Graw-Hill, México.

Romero, R y Zúnica L. (2005). Métodos estadísticos en ingeniería. Editorial

de la Universidad Politécnica de Valencia, España.

Walpole, R. Myers, R. y Myers, S. (1999), “Probabilidad y Estadística para

Ingenieros” Sexta edición, Editorial Pearson, México.